OpenNJet使用手册

V3.2.2

1 关于本手册

本手册面向于OpenNJet应用引擎的非管理员用户,即属于普通角色的用户,主要包括各个功能模块的操作指南。

2 OpenNJet应用引擎介绍

2.1 应用引擎技术介绍

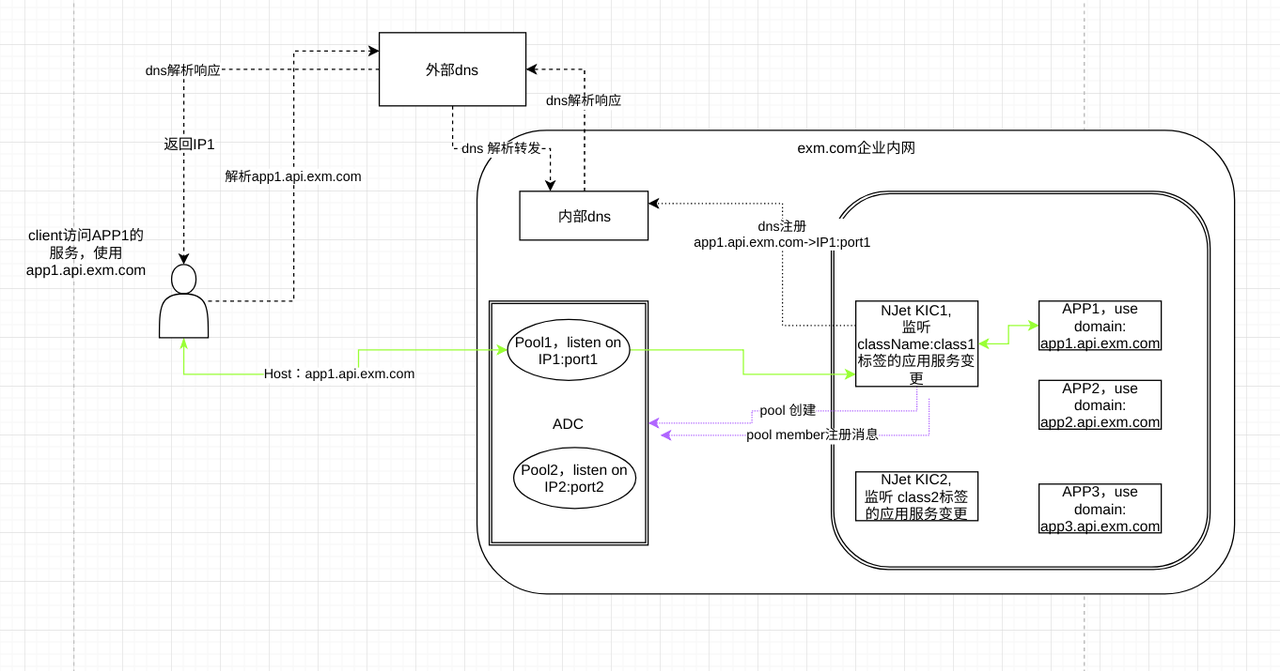

应用引擎是面向互联网和云原生应用提供的运行时组态服务程序。具备环境感知、安全控制、加速优化等能力,一般呈现为Web服务、流媒体服务、代理(Proxy)、应用中间件、API网关、消息队列等产品形态。

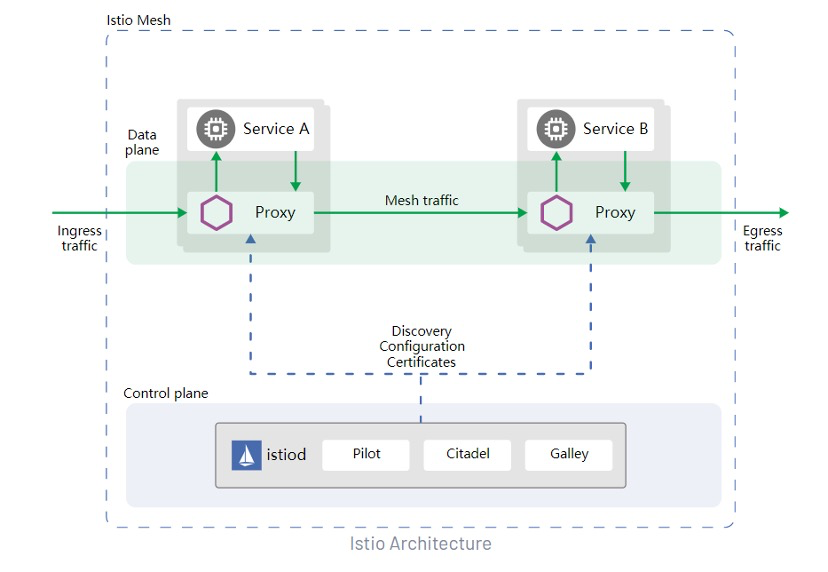

应用引擎在云原生架构中,除了提供南北向通信网关的功能以外,因为提供了服务网格中东西向通信、透明流量劫持、熔断、遥测与故障注入等新功能特性,其地位和作用在云原生架构中变得愈发重要。

OpenNJet最早是基于NGINX1.19基础,fork并独立演进的开源应用引擎,并随着NGINX版本迭代,吸收上游NGINX的更新,已经同步更新到NGINX1.23.1版本。OpenNJet的目标在于适应国内特定的技术规范及标准,如国密算法套件支持,并构建安全可控的云原生数据面,支撑我国云原生产业生态。作为底层引擎,OpenNJet利用动态加载机制可以实现不同的产品形态,如API网关、消息代理、出入向代理,负载均衡,WAF等等

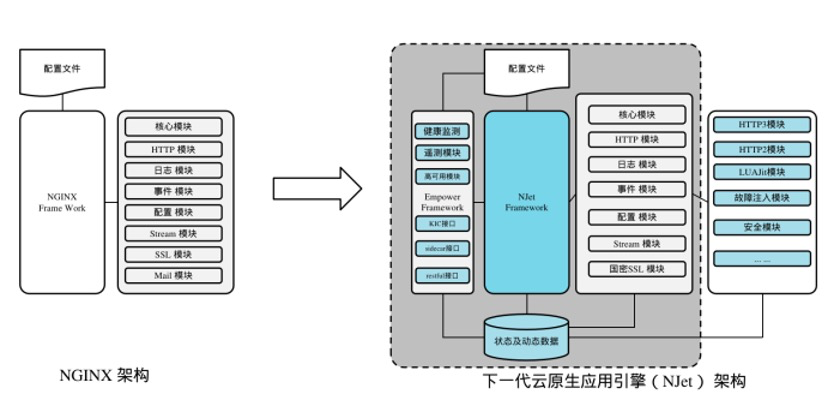

2.2 系统架构介绍

相比市面其他类型的API网关,高性能是NGINX主要的优点,但动态配置能力的缺乏一直受到业界的诟病。OpenNJet在NGINX的架构上进行了扩充,对其框架进行了改写,增加了 C 及可持久化的动态存储能力,解决了指令配置变更动态生效的关键问题,扩展了OpenNJet的应用场景。此外,业界对应用引擎可观测性的需求,需要应用引擎持续不断的采集性能指标、日志数据以及注入跟踪信息,但这对应用引擎的性能造成了不可忽视的影响,OpenNJet利用Copilot framwork隔离了业务处理及配置变更和指标采集,避免了遥测对性能的影响。作为云原生的应用引擎,OpenNJet需要支持业界流行的Ingress及Sidecar的api规范,基于动态配置+ Copilot framework架构,NJet可以通过不断更新独立的相关Copilot module,实现对响应标准规范的及时支持。

2.3 OpenNJet 编译与安装

2.3.1 编译环境:

i. 准备一台能够访问外网的

ii. CentOS Linux release 7.9.2009 (Core)

2.3.2 编译环境配置

2.3.2.1 CentOS 编译环境配置

配置yum源:

- 执行以下指令:sudo yum –enablerepo=extras install -q -y epel-release centos-release-scl-rh https://repo.ius.io/ius-release-el7.rpm

- sudo curl -o /etc/yum.repos.d/mercurial.repo https://www.mercurial-scm.org/release/centos7/mercurial.repo

- 上面步骤完成后,文件系统的目录/etc/yum.repos.d 将生成对应的repo文件

- [root@CDN102 home]# ls -al /etc/yum.repos.d/mercurial.repo

- -rw-r–r–. 1 root root 267 3月 7 11:26 /etc/yum.repos.d/mercurial.repo

yum 安装软件包:

sudo yum install -y devtoolset-8-make devtoolset-8-toolchain ca-certificates mercurial zlib-devel cmake3 ninja-build libunwind-devel pcre-devel openssl-devel libtool libtool-ltdl

创建符号连接:

- sudo ln -s /opt/rh/devtoolset-8/root/usr/bin/gcc /usr/local/bin/gcc

- sudo ln -s /opt/rh/devtoolset-8/root/usr/bin/c++ /usr/local/bin/c++

- sudo ln -s /opt/rh/devtoolset-8/root/usr/bin/cc /usr/local/bin/cc

- sudo ln -s /opt/rh/devtoolset-8/root/usr/bin/make /usr/local/bin/make

2.3.2.2 Ubuntu 编译环境配置

apt 安装软件包:

- sudo apt update

- sudo apt -y install gcc g++ make cmake libpcre2-dev libpcre3-dev libssl-dev zlib1g-dev perl m4 libtool automake autoconf vim-common unzip libcap2-bin

2.3.2.3 修改 ld.so.conf 配置

执行以下命令:

sudo bash -c 'echo "/usr/local/lib" >> /etc/ld.so.conf'

sudo ldconfig

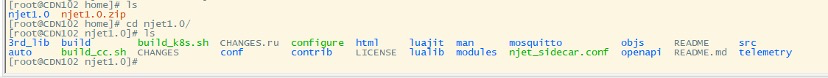

2.3.3 编译代码

把OpenNJet 1.0.zip 包上传到 /home 目录下。 并解压 unzip njet1.0.zip,如图:

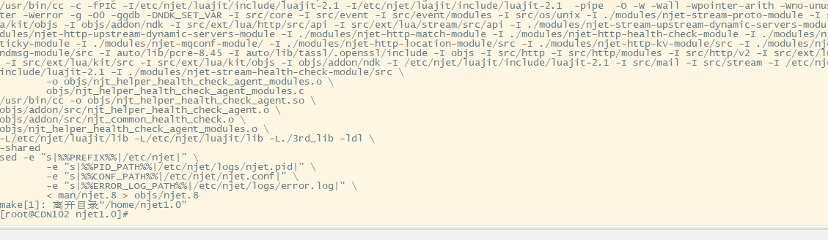

2.3.3.1 编译:OpenNJet

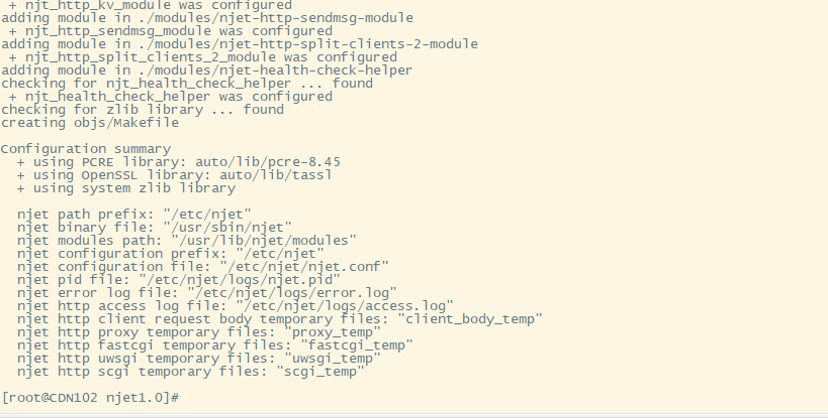

2.3.3.1.1 执行: sh build_cc.sh conf

2.3.3.1.2 执行:make

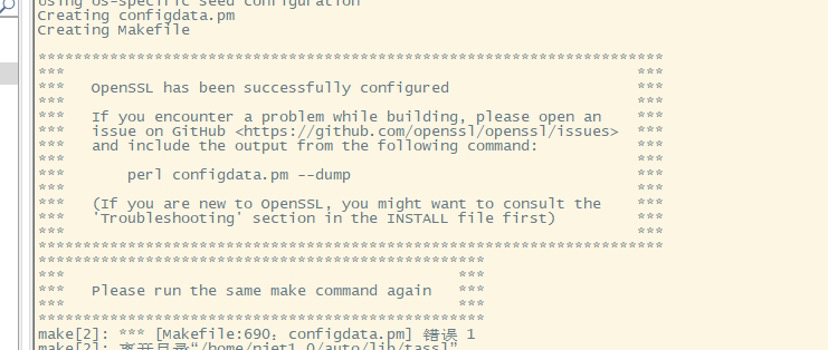

如果make 后,有如下提示:则继续 执行 make 指令。

2.3.3.1.3 正确编译完成:如图:

2.3.3.1.4 最后执行make install

3 系统功能

1.0目标是实现基本动态框架,为动态配置打下基础,全面改造SSL支持,从而支持国密,DTLS.初步实现sidecar的xDS接口,可作为边车应用在服务网格中。共涉及引擎内核,边车、出入口网关、web引擎、应用代理、安全、监控、可编程控制、api网关等4大类38项功能。在下述功能清单中,着重描述扩展、定制的功能,原生NGINX的能力可以参考 https://nginx.org/en/docs

3.1 基本使用

3.1.1 目录结构及功能说明

├── build 编译rpm/deb脚本

├── auto 自动检测系统环境以及编译相关的脚本

│ ├── cc 关于编译器相关的编译选项的检测脚本

│ ├── lib njet编译所需要的一些库的检测脚本

│ ├── os 与平台相关的一些系统参数与系统调用相关的检测

│ └── types 与数据类型相关的一些辅助脚本

├── conf 存放默认配置文件,在make install后,会拷贝到安装目录中去

├── contrib 存放一些实用工具,如geo配置生成工具(geo2njet.pl)

├── html 存放默认的网页文件,在make install后,会拷贝到安装目录中去

├── repos 存放yum数据源

├── doc njet的api文档

│ ├── swagger openapi 接口网页文档

│ ├── gui 前端展示页面文档

│ └── manual njet文档手册

├── luajit luajit

├── lualib lualib

├── modules njet动态模块以及util模块

└── src 存放njet的源代码

├── core njet的核心源代码,包括常用数据结构的定义,以及njet初始化运行的核心代码如main函数

├── event 对系统事件处理机制的封装,以及定时器的实现相关代码

│ └── modules 不同事件处理方式的模块化,如select、poll、epoll、kqueue等

├── http njet作为http服务器相关的代码

│ └── modules 包含http的各种功能模块

├── ext/lua lua模块

├── mail njet作为邮件代理服务器相关的代码

├── stream tcp/ udp 四层网络代理服务器相关的代码

├── misc 一些辅助代码,测试c++头的兼容性,以及对google_perftools的支持

└── os 主要是对各种不同体系统结构所提供的系统函数的封装,对外提供统一的系统调用接口

3.1.2 使用命令

3.1.2.1 显示帮助信息

njet -h

3.1.2.2 启动

njet -p /tmpr/njet/ -c conf/njet.conf

常见启动参数:

-p 指定prefix配置文件路径,不指定,默认/etc/njet

-c 指定配置文件,不指定,默认njet.conf

-e 指定error 日志文件

3.1.2.3 测试配置信息是否有错误

njet -t

3.1.2.4 显示版本

njet -v

3.1.2.5 显示编译阶段的参数

njet -V

3.1.2.6 快速停止

njet -s stop 或者 kill -TERM {进程id}

3.1.2.7 优雅停止服务

njet -s quit 或者 kill -QUIT {进程id}

3.1.2.8 重新加载配置

njet -s reload 或者 kill -HUP {进程id}

3.2 CoPilot

copilot类似于NGINX中的helper,但通过配置helper指令,实现装载不同的helper实现。从而实现不同的功能。目前的OpenNJet的事件总线、控制平面集成接口都是通过其设置。

copilot框架依赖mqconf提供的helper指令:

指令说明:

| Syntax | helper tag so_file conf_file; |

|---|---|

| Default | --- |

| Context | main |

参数说明:

|

参数名称 |

是否必须 |

参数说明 |

|

tag |

是 |

指定一个名字标签 |

|

so_file |

是 |

so文件 |

|

conf_file |

是 |

配置文件 |

Copilot so 规范

so实现以下接口:

1)unsigned int njt_helper_check_version(void) 当前版本是1 #define NJT_HELPER_VER 1

2)void njt_helper_run(helper_param param)

#define NJT_HELPER_CMD_NO 0 #define NJT_HELPER_CMD_STOP 1 #define NJT_HELPER_CMD_RESTART 2

typedef unsigned int (helper_check_cmd_fp)(void ctx); typedef struct { size_t conf_fn_len; u_char conf_fn_data; helper_check_cmd_fp check_cmd_fp; void ctx; } helper_param;

3)unsigned int njt_helper_ignore_reload(void)

返回1,表示该so的copilot进程,不会在reload的时候重启。

返回0,表示该so的copilot进程,会在reload的时候重启。

注1:so可以不实现该接口。若不实现,则等同于返回0。

注2:如果so实现该接口并且返回1,那么在reload的时候该so的copilot进程不会重启,但是有一点需要注意:reload的时候配置文件中需保留原helper指令,这是配置上的强制要求,不满足此要求会导致reload失败。

so 需要实现以下操作:

1)在njt_helper_run的事件循环中,调用param.check_cmd_fp() 例如: unsigned int cmd; cmd = param.check_cmd_fp(param.ctx);

2)根据接收到的命令进行处理, 接收到NJT_HELPER_CMD_STOP命令,要进行停止操作; 接收到NJT_HELPER_CMD_RESTART命令,要进行停止操作。

注意:NJT_HELPER_CMD_RESTART 为预留命令

3.2.1 copilot:ctrl

该模块是一个基础模块,给 http-sendmsg 和 http_health_check 等模块提供运行环境。

为了运行该模块,需要在主配置文件中进行配置:

下面为示例配置:

helper ctrl objs/njt_helper_ctrl_module.so njet_ctrl.conf;

该模块自身的配置,即上面主配置文件中helper指令中指定的配置文件的内容。

配置的指令分为两类:

1)OpenNJet中标准的指令;

- 需要注意:用 error_log 和 access_log 指令指定的log文件要不同于主配置文件中的log文件。

2)通过 load_module 指令加载的动态模块中扩展出来的指令。

配置示例如下:

C++

load_module /home/njet/modules/njt_http_sendmsg_module.so;

load_module /home/njet/modules/njt_http_health_check_helper.so;

user njet njet;

error_log logs/error_ctrl.log info;

events {

worker_connections 1024;

}

http {

dyn_sendmsg_conf conf/iot_msg.conf;

access_log logs/access_ctrl.log combined;

server {

listen 8443;

location / {

return 200 "NJet control_plane stub\n";

}

location /hc {

health_check_api;

}

}

}

3.2.2 copilot:broker

该模块提供消息服务端功能,要开启该功能在njet.conf 的 main block 中添加如下指令:

helper broker /home/njet/modules/njt_helper_broker_module.so conf/mqtt.conf; 注意:(rpm 和deb 包安装时,njet.conf 配置中是不带conf/mqtt.conf的)

mqtt.conf Message Broker 配置文件

|

配置项

|

必须修改 |

配置说明

|

|

log_dest |

否 |

日志输出方法,一般配置为文件输出,配置值为file 文件名(绝对路径) 默认: $PREFIX/logs/mosquitto.log |

|

log_type |

否

|

日志级别: debug, error, warning, notice, information,mqtt库中的日志输出方式和java 中的不一样,配置了某个日志级别,只有该日志级别的消息才会输出到日志中, 因此需要为需要的日志级别单独配置一行。默认: error |

|

listener |

否 |

监听端口及地址 , 默认: 0 $PREFIX/data/mosquitto.sock |

|

allow_anonymous |

否 |

是否允许匿名连接,目前配置为true |

|

persistence |

否 |

是否开启消息持久化 (true, false), 默认: true |

|

autosave_on_changes |

否 |

是否有消息时进行自动保存 默认: true |

|

autosave_interval |

否 |

当自动保存开启时,当新消息个数大于这个配置值时,将触发保存操作 默认: 1 |

|

persistence_location |

否 |

持久化文件保存路径,将在该路径下创建 mosquitto.db , 默认: $PREFIX/data |

配置都会有默认值,建议只配置日志级别。

C++

log_type error

3.2.3 copilot:ha

该模块通过vrrp协议提供多个njet实例的高可用功能。

VRRP 的相关介绍可以参见网页:

配置说明:

▪ 要开启该功能在njet.conf 的 main block 中添加如下指令:

njet配置文件增加:

helper ha /usr/lib/njet/modules/njt_helper_ha_module.so vrrp.conf;

▪ - 基于从流水线上下载的压缩包:该模块需要依赖外部的so动态库,将 libha_emb.* 拷贝到 /usr/local/lib 目录下,执行下面命令,确认/usr/local/lib 目录已经配置到/etc/ld.so.conf(注意: 如果从源码编译 ,make install 阶段是会将 这个 libha_emb.* 自动拷贝到 /usr/local/lib ,无需执行下面命令 )

Bash

cp -a work/usr/local/lib/libha_emb.* /usr/local/lib

▪ 由于设置网卡vip , 需要一定的权限,opennjet 在非root 用户启动情况下,需要预先设置对应的权限

Bash

sudo setcap cap_net_bind_service,cap_net_admin,cap_net_raw+eip njet

▪ 生效配置

Bash

sudo ldconfig

增加vrrp.conf 配置文件说明:

|

配置项

|

必须修改 |

配置说明

|

|

vrrp_instance |

是 |

设置的VRRP的实例名,string类型 |

|

state |

是 |

设置当前节点的初始化状态,状态为MASTER或者BACKUP。 |

|

interface |

是 |

可以绑定vip的接口名称,比如eth0,bond0,br0。 |

|

virtual_router_id

|

是 |

设置虚拟路由器惟一标识,范围:0-255,同属一个集群的多个njet节点该id相同, 不同的njet集群该值必须不同,务必要确认在同一网络中此值必须唯一。 |

|

priority |

是 |

设置当前njet节点的优先级,范围:1-254,值越大优先级越高 |

|

virtual_ipaddress |

是 |

设置虚拟IP对应的子网掩码。 |

配置样例:

Bash

vrrp_instance m{

state MASTER

interface eth0

virtual_router_id 32

priority 100

virtual_ipaddress {

10.1.0.22/24

}

}

HA copilot 模块的对应日志是 $PREFIX/logs/njet_vrrp.log, 日志中将显示 ha 模块设置VIP时的一些相关信息, 配置文件中有错误的配置项,日志中将显示对应的错误位置及加载后的默认值。

Bash

Thu Jun 01 17:18:11.192916235 2023: (/usr/local/njet/conf/vrrp.conf: Line 2) (m) unknown state 'Back', defaulting to BACKUP

Thu Jun 01 17:18:11.193003054 2023: (/usr/local/njet/conf/vrrp.conf: Line 5) number '1000' outside range [1, 255]

Thu Jun 01 17:18:11.193027778 2023: (/usr/local/njet/conf/vrrp.conf: Line 5) (m) Priority not valid! must be between 1 & 255. Using default 100

Thu Jun 01 17:18:11.193230339 2023: gratuitous_arp_init end

Thu Jun 01 17:18:11.193271876 2023: start up end

Thu Jun 01 17:18:11.193536733 2023: (m) Entering BACKUP STATE (init)

Thu Jun 01 17:18:14.803010859 2023: (m) Entering MASTER STATE

配置的动态加载

Copilot 配置的动态设置在后续的版本中,将进行统一的考虑及设计。

目前 HA Copilot 已经屏蔽NJet 的 Reload 信号, vrrp 相关的配置,如果进行了手工编辑, 需要给 HA Copilot 进程发送 HUP 信号。 (kill -HUP $PID, 其中 $PID 为 HA Copilot 的进程ID )

3.3 动态配置框架

OpenNJet 提供基于eventbus构建的消息总线,其包括copilot:broker,动态配置 stub 模块 njet_http_kv,sendmsg 模块 njet_http_sendmsg 模块。

如上图所示意, OpenNJet的动态配置一般由控制面发送配置消息,不同的 worker 通过加载动态配置 stub,监听不同的消息,并回调不同的处理函数。

3.3.1 kv模块配置

在 http block 下,指定该模块的配置文件:

C++

http {

dyn_kv_conf conf/iot.conf;

}

iot.conf MQTT 客户端配置

|

配置项 |

必须修改 |

配置说明 |

|

broker_addr |

否 |

MQ broker 地址。默认: unix:$PREFIX/data/mosquitto.sock |

|

log_type

|

否 |

日志级别: debug, error, warning, notice, information,不同的日志级别需要单独配置一行。默认: error |

|

topic |

否 |

默认订阅的主题 /cluster/+/kv_set/# 用于kvstore 值的设置 /dyn/# 用于动态 location 更新 /rpc/# 用于发送rpc消息 |

|

keepalive |

否 |

给服务端发送PING命令的间隔时间。 默认:30 |

|

kv_store_dir |

否 |

Key value store 持久化文件路径。 默认: $PREFIX/data |

|

protocol_version

|

否 |

使用的协议版本,要支持 request response消息, 必须填 5 。 默认:5 |

配置都会有默认值,建议只配置日志级别

C++

log_type error

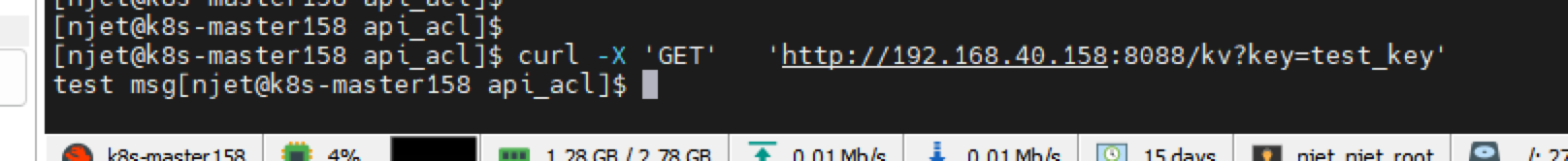

3.3.2 Sendmsg

要开启该功能, 需在njet_ctrl.conf 的 main block 中加载该模块:

load_module /home/njet/modules/njt_http_sendmsg_module.so;

并在 http block 下,指定该模块的配置文件:

C++

http {

dyn_sendmsg_conf conf/iot_ctrl.conf;

server {

...

location /kv {

dyn_sendmsg_kv;

}

...

}

}

dyn_sendmsg_kv 配置不是必须的, 这个是对外提供了 kv 值设置及查询的 http API 接口。

iot_ctrl.conf MQTT 客户端配置

|

配置项 |

必须修改 |

配置说明 |

|

broker_addr |

否 |

MQ broker 地址. 默认:unix:$PREFIX/data/mosquitto.sock |

|

log_type

|

否

|

日志级别: debug, error, warning, notice, information,不同的日志级别需要单独配置一行。 默认:error |

|

keepalive |

否 |

给服务端发送PING命令的间隔时间. 默认:30 |

|

kv_store_dir |

否 |

Key value store 持久化文件路径. 默认:$PREFIX/data |

|

protocol_version

|

否 |

使用的协议版本,要支持 request response消息, 必须填 5 . 默认:5 |

配置都会有默认值,建议只配置日志级别

C++

log_type error

3.4 国密支持

3.4.1 功能说明

使用国密版 OpenSSL 库来使用 SM2、SM3、SM4 算法(以下简称为SM234算法)。

SM234 算法使用双证书,包括签名证书和加密证书,这是国密支持在证书上的一个特点。

同时,还要求使用的国密版 OpenSSL 兼容标准 OpenSSL。

根据 OpenNJet 的使用场景,国密支持的场景也细分为 Server 和反向代理两种场景。

3.4.2 指令****说明

3.4.2.1 ssl_ntls

| Syntax: | ssl_ntls on | off; |

|---|---|

| Default: | — |

| Context: | http,server |

新增 ssl_ntls 指令,用于指定是否使用ntls。

3.4.2.2 ssl_certificate

| Syntax: | ssl_certificate file [file]; |

|---|---|

| Default: | — |

| Context: | http,server |

修改 ssl_certificate 指令,可以配置一个或两个证书,当配置两个证书时,前一个是签名证书,后一个是加密证书。

3.4.2.3 ssl_certificate_key

| Syntax: | ssl_certificate_key file [file]; |

|---|---|

| Default: | — |

| Context: | http,server |

修改 ssl_certificate_key 指令,可以配置一个或两个秘钥,当配置两个秘钥时,前一个是签名密钥,后一个是加密密钥。

3.4.2.4 proxy_ssl_ntls

| Syntax: | proxy_ssl_ntls on | off; |

|---|---|

| Default: | — |

| Context: | http, server, location |

新增 proxy_ssl_ntls 指令,用于指定是否使用ntls。

3.4.2.5 proxy_ssl_certificate

| Syntax: | proxy_ssl_certificate file [file]; |

|---|---|

| Default: | — |

| Context: | http, server, location |

修改 proxy_ssl_certificate 指令,可以配置一个或两个证书,当配置两个证书时,前一个是签名证书,后一个是加密证书。

3.4.2.6 proxy_ssl_certificate_key

| Syntax: | proxy_ssl_certificate_key file [file]; |

|---|---|

| Default: | — |

| Context: | http, server, location |

修改 proxy_ssl_certificate_key 指令,可以配置一个或两个秘钥,当配置两个秘钥时,前一个是签名密钥,后一个是加密密钥。

3.4.3 配置说明

OpenNJet 作为 Server 时国密支持需要增加双证书的配置:

server {

listen 443 ssl;

server_name localhost;

ssl_ntls on;

ssl_protocols TLSv1 TLSv1.1 TLSv1.2;

ssl_ciphers "ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS";

ssl_verify_client off;

# 原RSA证书

ssl_certificate /home/certs/cert/sslserver.crt;

ssl_certificate_key /home/certs/cert/sslserver.key;

# 国密支持添加的证书

ssl_certificate certs/SS.crt certs/SE.crt;

ssl_certificate_key certs/SS.key certs/SE.key;

location / {

root html;

index index.html index.htm;

}

}

NJet作为proxy时国密支持配置:

server {

listen 8080;

server_name localhost;

# 其他配置,例如:

location / {

proxy_ssl_ntls on;

proxy_ssl_verify on;

proxy_ssl_trusted_certificate certs/CA.crt;

proxy_ssl_certificate certs/CS.crt certs/CE.crt;

proxy_ssl_certificate_key certs/CS.key certs/CE.key;

proxy_ssl_ciphers "ECC-SM2-WITH-SM4-SM3:ECDHE-SM2-WITH-SM4-SM3:RSA";

proxy_pass https://192.168.183.111:443;

}

}

3.4.4 功能验证

3.4.4.1 验证服务器对国密的支持

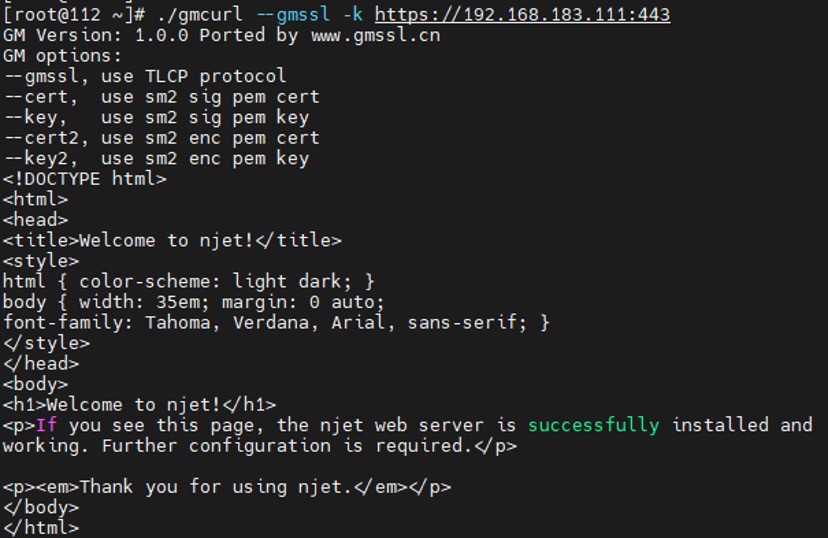

验证工具为分别为密信浏览器和gmcurl。

密信浏览器:

使用密信浏览器访问server:

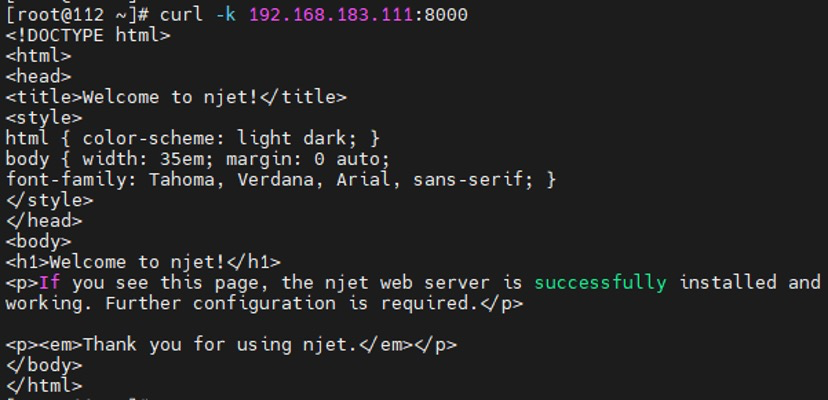

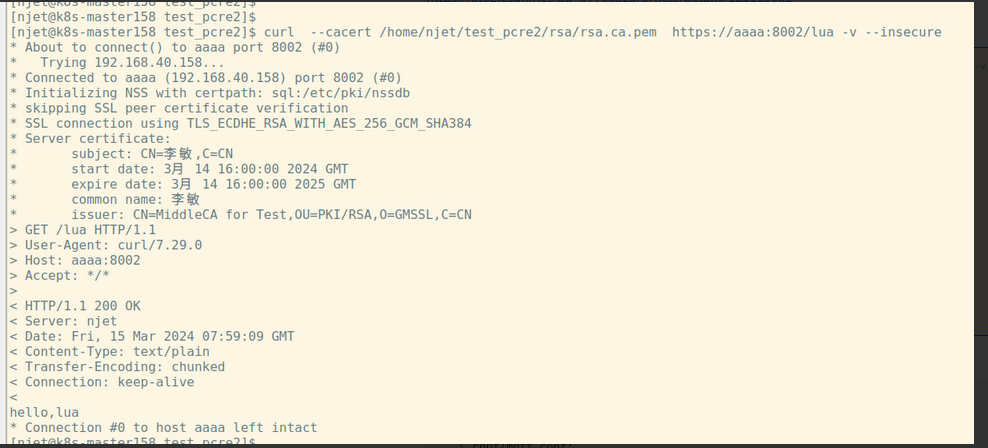

使用gmcurl访问server:

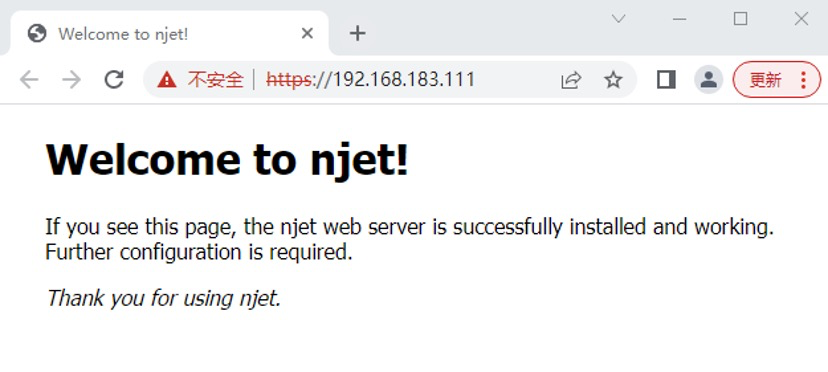

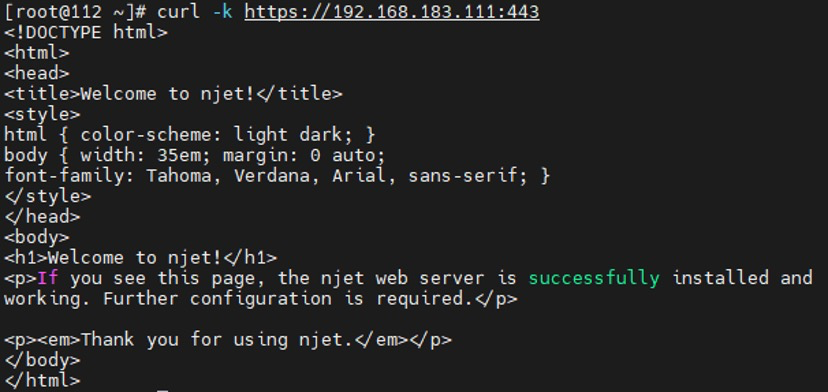

3.4.4.2 验证服务器对RSA证书的支持

上节的server的配置中分别指定了RSA证书和国密证书,再验证一下服务器对RSA证书的支持。验证工具为分别为Chrome浏览器和curl。

使用Chrome浏览器访问server:

使用curl访问server:

3.4.4.3 后端upstream使用国密验证

OpenNJet 作反向代理访问后端国密 upstream 服务器。验证工具为分别为 Chrome 浏览器和 curl 。

3.5 动态Location

3.5.1 功能说明

本系统支持对location模块的动态添加、删除,可以对locaiton进行便捷的配置和所需指令功能的添加使用。

该模块支持ACL控制,详见章节3.26。

3.5.2 配置说明

请参考标准配置文件章节配置,全量配置即可配置上此功能,但请注意一定要包含以下指令和块:

njet.conf配置文件中务必有此模块

load_module modules/njt_http_location_module.so;

ctrl.conf配置文件中务必包含这些模块

load_module modules/njt_http_sendmsg_module.so;

load_module modules/njt_http_location_api_module.so;

http {

server {

listen 8081;

location /api {

dyn_module_api;

}

}

}

动态location,配置ACL控制

load_module modules/njt_http_sendmsg_module.so;

load_module modules/njt_http_location_api_module.so;

server {

listen 8081;

location /api {

dyn_module_api;

limit_except GET {

auth_basic "NJET API";

auth_basic_user_file /etc/njet/htpasswd;

}

}

}

3.5.3 API 说明

动态location增加说明:

|

配置项

|

必填 |

配置说明

|

|

type |

是 |

“add” 添加location |

|

addr_port |

是 |

添加的主机的,port 端口。 例如:"192.168.40.203:8000", 或 “0.0.0.0:8000” |

|

server_name |

是 |

主机的server_name, 例如:"cluster.tmlake.com" |

|

locations |

是 |

List 对象列表。 对象字段: location_rule,//可以为空。 location_name, //不能为空。 location_body, //location_body 或 proxy_pass 必须有一个不为空。结尾不要带; proxy_pass //location_body 或 proxy_pass 必须有一个不为空。结尾不要带; //proxy_pass 后面只能跟配置文件预定义的upstream 名字。 其他的不支持

|

说明:

location_body 或 proxy_pass 字段均可以为空,结尾不要带;

proxy_pass 现在支持http,https,ip地址,unix socket,域名,变量等。(例如:http://backend1、https://backend1、http://127.0.0.1:443、http://$upstream_name、http://unix:/var/lib/njet/njet-502-server.sock等)

动态location删除说明:

|

配置项

|

必填 |

配置说明

|

|

type |

是 |

“del” 删除location |

|

addr_port |

是 |

添加的主机的,port 端口。 例如:"192.168.40.203:8000", 或 “0.0.0.0:8000” |

|

server_name |

是 |

主机的server_name, 例如:"cluster.tmlake.com" |

|

location_rule |

否 |

Location 的表达式, 例如:“=” 或 其他的正则式 |

|

location_name |

是 |

location的名字,也就是表达式后面的。 例如: “/” 或 “/test” |

说明:

添加的嵌套location, 删除时只能通过根location一并删除,不支持直接删除子location。

3.5.4 调用样例

3.5.4.1 post 添加

回显{“code”:0,“msg”:“success."}即为添加成功。

curl -v -s -X POST http://127.0.0.1:8081/api/v1/dyn_loc -d '{"type":"add","addr_port":"0.0.0.0:8899","server_name":"cluster1","locations":[{"location_rule":"","location_name":"/","location_body":"","proxy_pass":"http://http1"}]}'

> POST /dyn_location HTTP/1.1

> User-Agent: curl/7.29.0

> Host: 127.0.0.1:8081

> Accept: */*

> Content-Length: 149

> Content-Type: application/x-www-form-urlencoded

>

* upload completely sent off: 149 out of 149 bytes

< HTTP/1.1 200 OK

< Server: njet/1.23.1

< Date: Mon, 22 May 2023 07:22:30 GMT

< Content-Type: application/json

< Content-Length: 27

< Connection: keep-alive

<

* Connection #0 to host 127.0.0.1 left intact

{"code":0,"msg":"success."}

3.5.4.2 查询

添加成功后,可以对所添加的 location 对应的上游资源进行请求,已验证是否可以正常对资源进行请求查询。

Bash

curl -v -s http://127.0.0.1:8899/1.html

> GET /1.html HTTP/1.1

> User-Agent: curl/7.29.0

> Host: 127.0.0.1:8899

> Accept: */*

>

< HTTP/1.1 200 OK

< Server: njet/1.23.1

< Date: Fri, 31 Mar 2023 03:34:00 GMT

< Content-Type: text/html

< Content-Length: 49

< Connection: keep-alive

< ETag: W/"49-1641534167000"

< Last-Modified: Fri, 07 Jan 2022 05:42:47 GMT

< Vary: Accept-Encoding

< X-Cache-Status: STALE

< Accept-Ranges: bytes

<

<html>

<head></head>

* Connection #0 to host 127.0.0.1 left intact

<body>111111</body></html>

3.5.4.3 put 禁用删除

动态location功能也支持动态进行删除操作,以下将展示如何进行验证:

进行动态删除location操作:

Bash

curl -v -s -X PUT http://127.0.0.1:8081/dyn_location -d '{"type":"del","addr_port":"0.0.0.0:8899","server_name":"cluster1","location_rule":"","location_name":"/"}'

> PUT /dyn_location HTTP/1.1

> User-Agent: curl/7.29.0

> Host: 127.0.0.1:8081

> Accept: */*

> Content-Length: 105

> Content-Type: application/x-www-form-urlencoded

>

* upload completely sent off: 105 out of 105 bytes

< HTTP/1.1 200 OK

< Server: njet/1.23.1

< Date: Mon, 22 May 2023 07:38:36 GMT

< Content-Type: application/json

< Content-Length: 27

< Connection: keep-alive

<

* Connection #0 to host 127.0.0.1 left intact

{"code":0,"msg":"success."}

再次请求之前的上游资源,可以发现已经请求失败,删除成功:

Bash

curl -v -s http://127.0.0.1:8899/1.html

> GET /1.html HTTP/1.1

> User-Agent: curl/7.29.0

> Host: 127.0.0.1:8899

> Accept: */*

>

< HTTP/1.1 404 Not Found

< Server: njet/1.23.1

< Date: Mon, 22 May 2023 07:39:55 GMT

< Content-Type: text/html

< Content-Length: 152

< Connection: keep-alive

<

<html>

<head><title>404 Not Found</title></head>

<body>

<center><h1>404 Not Found</h1></center>

<hr><center>njet/1.23.1</center>

</body>

</html>

* Connection #0 to host 127.0.0.1 left intact

3.5.5location功能增强

3.5.5.1功能说明

1)支持所有变量匹配

2)支持逻辑与和逻辑或运算

3)顺序匹配多添加location,都不满足走正常location 路径匹配。

4)操作符:=,!= ,正则。

3.5.5.2 静态配置文件示例

JSON

server {

listen 80;

location ( $http_host = www.test.com && $http_user_agent ~= windows) {

return 200 " www.test.com && http_user_agent ~= window ";

}

location ( $uri = "/delete" || $request_method = DELETE) {

return 200 $remote_addr":delete";

}

location ( $remote_addr = "192.168.40.203" && $request_method = PUT && $uri ~* .png$) {

proxy_pass

}

location ( $remote_addr = "192.168.40.203" && $request_method = PUT && $uri ~* .png$) {

proxy_pass http://backend1;

}

}

3.5.5.3 动态新增方法示例

1)多个与(&&)变量locaiton添加

JSON

{

"type": "add",

"addr_port": "0.0.0.0:8888",

"server_name": "cluster1",

"locations": [{

"location_rule": "",

"location_name": "( $remote_addr = \"192.168.40.203\" && $request_method = PUT && $uri ~* .png$)",

"location_body": "return 200 $remote_addr\":PUT*.png\""

}]

}

2)多个与(&&)否(!=)变量添加

JSON

{

"type": "add",

"addr_port": "0.0.0.0:8888",

"server_name": "cluster1",

"locations": [{

"location_rule": "",

"location_name": "( $remote_addr = \"192.168.40.203\" && $request_method = PUT && $uri != \"/1.png\")",

"location_body": "return 200 $remote_addr\":PUT*.png\""

}]

}

3)多个或(||)变量添加

JSON

{

"type": "add",

"addr_port": "0.0.0.0:8888",

"server_name": "cluster1",

"locations": [{

"location_rule": "",

"location_name": "( $uri = \"/delete\" || $request_method = DELETE || $remote_addr = \"192.168.40.203\")",

"location_body": "return 200 $remote_addr\":delete\""

}]

}

4)正则方式添加

JSON

{

"type": "add",

"addr_port": "0.0.0.0:8888",

"server_name": "cluster1",

"locations": [{

"location_rule": "",

"location_name": "($uri ~* .(mp4|jpg|gif)$ && $server_port ~ \\d)",

"location_body": "",

"proxy_pass":"http://http1"

}]

}

- 与(||)或(&&)多变量添加

JSON

{

"type": "add",

"addr_port": "0.0.0.0:8888",

"server_name": "cluster1",

"locations": [{

"location_rule": "",

"location_name": "( $remote_addr = \"192.168.40.203\" || $uri ~* .(mp4|jpg|gif)$ && $request_method = PUT)",

"location_body": "",

"proxy_pass":"http://http1"

}]

}

3.5.5.4注意事项

1)mirror 指令:

在使用mirror指令时location 条件一定要包含uri 的条件,避免重新路由时,条件总是满足类似($remote_addr = “192.168.40.104” && $server_port = “6969”)这种不包含uri路径的条件,造成mirror 失败。

JSON

location ($uri = "/" && $remote_addr = "192.168.40.104" && $server_port = "6969"){

mirror /mirror1;

mirror /mirror2;

proxy_pass http://backend;

}

2)表达式location的执行顺序为由上到下、由先到后依次执行,在添加表达式location时需要注意先后顺序。

3)location 名称:因在增强功能中需要对表达式进行处理,所以NJet会将”(“作为关键词进行处理,在locaiton使用中,无法单独将location_name设置为”(“起始进行使用,如若检测到location_name是以”(“起始,而没有”)“时,njet即会出现报错,不予处理。

例如:

location ( {

return 200 ok;

}

在nginx下能正常使用。 而在NJet 里 会被识别不完整的表达式,并提示错误。

3.6 主动健康检查

3.6.1 功能说明

主动健康检查与被动健康检查:主动健康检查由 OpenNJet 主动发起请求测试上游服务是否正常,如不正常则及时剔除对应服务;被动健康检查由 OpenNJet 检测上游服务的异常返回发现服务异常,不能主动感知上游服务状态。

helper 进程主动健康检查:可以实现健康检查由独立进程完成,对 work 进程无影响,完成后修改共享内存完成 upstream 状态回写。

该模块支持ACL控制,详见章节3.26。

3.6.2 控制面指令说明

3.6.2.1 语法说明

health_check_api

语法: health_check_api ;

默认值: —

允许配置位置: location

在当前location开启健康检查API。

3.6.2.2 配置示例

load_module modules/njt_helper_health_check_module.so;

load_module modules/njt_http_sendmsg_module.so;

http{

dyn_sendmsg_conf conf/iot-ctrl.conf;

include mime.types;

server {

listen 8081;

location /api {

dyn_module_api;

}

}

}

主动健康检查,配置ACL控制

load_module modules/njt_helper_health_check_module.so;

load_module modules/njt_http_sendmsg_module.so;

server {

listen 8081;

location /api {

dyn_module_api;

limit_except GET {

auth_basic "NJET API";

auth_basic_user_file /etc/njet/htpasswd;

}

}

}

3.6.3 数据面指令说明

3.6.3.1 语法说明

health_check

语法: health_check mandatory | persistent;

默认值: —

允许配置位置: location

|

配置项

|

必填 |

配置说明

|

|

health_check |

是 |

|

|

mandatory |

是 |

配置后,静态文件server,api,域名解析出的server 初始状态都是checking 状态(不做业务,等待健康检查),会立即进行健康检查,然后更新结果为 health 或 unhealth |

|

persistent |

否 |

配置之后reload 后,会保留上次的健康状态。 直到下次健康检查。 |

3.6.3.2 配置示例

upstream backend1 {

zone backend1 128k;

server 192.168.40.144:5555;

health_check mandatory persistent;

}

3.6.4 API说明

格式说明健康检查配置项参数说明

JSON

{

"interval": "3s",

"visit_interval": "2s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"port": 13470

}

# interval 主动健康检查频率

# visit_interval 健康检查时,如果指定的时间间隔内该server被客户端访问过,则该server跳过此次健康检查,interval > visit_interval

# timeout 超时时间

# jitter 设置健康检查项定时器最大偏差。防止所有检查项同时触发。默认1秒。

# passes 连续通过passes次检测,更新peer为up状态

# fails 连续不通过fails次检测,更新peer为unhealthy状态

# port 指定peer端口,如果不指定,使用upstream中peer设置的端口

3.6.4.1 HTTP健康检查

JSON

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"port": 13470

"http": {

"header":["host"],

"uri": "/body",

"body": "~ ok",

"status": "200 204"

}

}

部分API字段补充

健康检查 HTTP > status 配置方式

| 配置内容 | 判定为健康的描述 |

|---|---|

| 200 | http返回状态码为200 |

| ! 500 | http返回状态码不是500.!与500之间需要有空格符 |

| 200 204 | http返回状态码是200 或者 204 |

| ! 301 302 | http返回状态码不是301且不是302。!与status之间需要有空格符 |

| 200-399 | http返回状态码是200到399的,包含200和399 |

| !400-599 | http返回状态码不是400到599的,包含400和599 !与status之间需要有空格符 |

| 301-303 307 | http返回状态码是301到303的,包含301和303,或者307 |

配置内容判定为健康的描述

200http返回状态码为200

! 500http返回状态码不是500

200 204http返回状态码是200 或者 204

! 301 302http返回状态码不是301且不是302

200-399http返回状态码是200到399的,包含200和399

!400-599http返回状态码不是400到599的,包含400和599

301-303 307http返回状态码是301到303的,包含301和303,或者307

健康检查 http > header 配置方式

| 配置内容 | 判定为健康的描述 |

|---|---|

| Content-Type = text/html | 返回header中存在"Content-Type” header,且header内容为"text/html" |

| Content-Type != text/html | 返回header中存在"Content-Type" header,且值为除“text/html"外任意内容。 |

| Connection ~ close | 返回header中存在 Connection,且值可以匹配表达式"~ close" |

| Connection !~ close | 返回 header中存在 Connection,且值可以不匹配表达式"~ close“ |

| Host | 返回 header中存在 Host |

| !X-Accel-Redirect | 返回 header中不存在 X-Accel-Redirect |

健康检查 http > body配置方式

| 配置内容 | 判定为健康的描述 |

|---|---|

| ~ Welcome | 返回body内容匹配表达式”~ Welcome“ |

| !~ Welcome | 返回body内容不匹配表达式”!~ Welcome“ |

3.6.4.2 Stream健康检查

3.6.4.2.1 健康检查TCP配置方式

请求BODY

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": { /* 开启四层健康检查 */

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

}

}

请求命令

curl -s http://127.0.0.1:8081/api/v1/hc/stcp/demo -XPOST -d '{"interval": "3s","jitter": "1s","timeout": "10s","passes": 2, "fails": 1,"stream": {"send": "zhao\\x6B\\x61\\x6E\\x67","expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you"}}'

返回

{

"code": 0,

"msg": "success"

}

参数说明:

stcp为四层健康检查配置的关键字,表示使用TCP协议

demo为对应下发的upstream的name

stream 为stream类型的上游健康检查指定参数。

stream.send为期望发送的文本,对于不可见字符,可使用16进制方式表示,格式为\\x[a-f0-9]{1,2},配置时可与普通文本串混合使用。

stream.expect 为期望收到的文件内容串,对于不可见字符,可使用16进制方式表示,\\x[a-f0-9]{1,2},配置时可与普通文本串混合使用

3.6.4.2.2 健康检查TCP + TLS配置方式

请求BODY

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": { /* 开启四层健康检查 */

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

},

"ssl": {

"enable": true, /* 是否启用TLS */

"ntls": true, /* 是否是国密算法 */

"ciphers":"ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS" /* 支持算法 */

}

}

请求命令

curl -s http://127.0.0.1:8081/api/v1/hc/stcp/demo -XPOST -d '{"interval": "3s","jitter": "1s","timeout": "10s","passes": 2, "fails": 1,"stream": {"send": "zhao\\x6B\\x61\\x6E\\x67","expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you"},"ssl": {"enable": true,"ntls": true,"ciphers":"ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS" }}'

返回

{

"code": 0,

"msg": "success"

}

参数说明:

stcp 为四层健康检查配置的关键字,表示使用TCP协议

demo 为对应下发的upstream的name

stream 意义同 “健康检查TCP配置方式”

ssl TLS相关配置

ssl.enable 是否启tls,默认 false

ssl.ntls 是否是国密算法.

ssl.ciphers 支持的算法 默认"DEFAULT"

3.6.4.2.3 健康检查UDP配置方式

JSON

请求BODY

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": { /* 开启四层健康检查 */

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

}

}

请求命令

curl -s http://127.0.0.1:7071/hc/1/hc/sudp/tmux -XPOST -d '{"interval": "3s","jitter": "1s","timeout": "10s","passes": 2, "fails": 1, "stream": {"send": "zhao\\x6B\\x61\\x6E\\x67","expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you"}}'

返回

{

"code": 0,

"msg": "success"

}

参数说明:

sudp为四层健康检查配置的关键字

tmux为对应下发的upstream的name

stream 意义同 “健康检查TCP配置方式”

UDP方式不支持TLS

请求命令

curl -s http://127.0.0.1:7071/hc/1/hc/sudp/demo -XPOST -d '{"interval": "3s","jitter": "1s","timeout": "10s","passes": 2, "fails": 1,"stream": {"send": "zhao\\x6B\\x61\\x6E\\x67","expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you"},"ssl": {"enable": true,"ntls": true,"ciphers":"ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS" }}'

返回

{

"code": 14,

"msg": "UDP does not support tls"

}

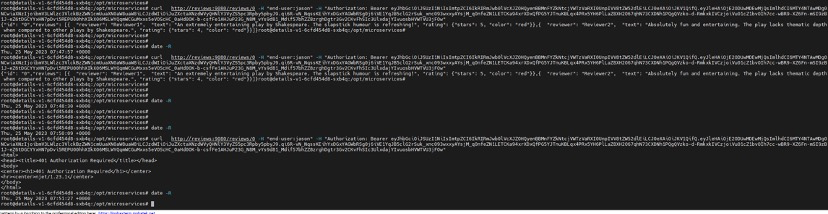

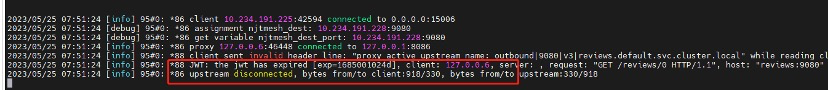

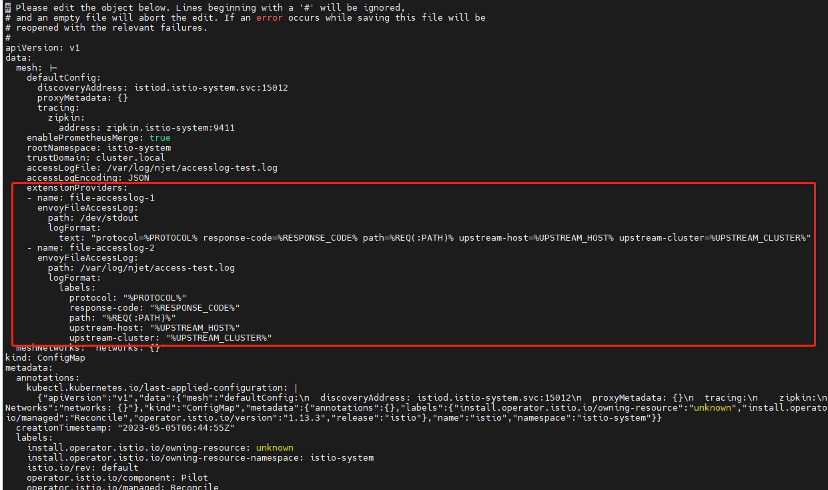

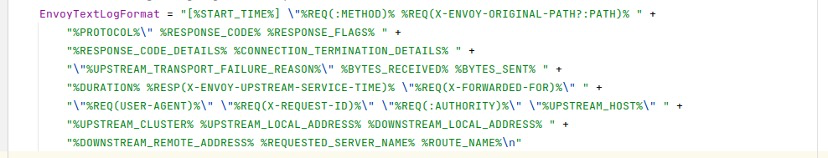

3.6.5 调用样例

以下请求请注意替换ip 、端口 、uri

3.6.5.1 增加新的健康检查

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/http/demo

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"http": {

"header": [

"Host"

],

"uri": "/test",

"body": "~ ok",

"status": "200 204"

},

"ssl": {

"enable": false

}

}

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:06:24 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.2 删除健康检查

请求

HTTP

DELETE http://127.0.0.1:8081/hc/1/hc/http/demo

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:06:21 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.3 查看健康检查列表

请求

GET http://127.0.0.1:8081/hc/1/hc

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:07:12 GMT

Content-Type: application/json

Content-Length: 44

Connection: keep-alive

[

{

"upstream": "demo",

"type": "http"

}

]

3.6.5.4 查看健康检查配置详情

请求

HTTP

GET http://127.0.0.1:8081/hc/1/hc/http/demo

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:07:14 GMT

Content-Type: application/json

Content-Length: 157

Connection: keep-alive

{

"interval": "3s",

"visit_interval": "2s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"http": {

"uri": "/test",

"status": "200",

"body": "~ ok",

"header": [

"Host"

]

}

}

3.6.5.5 http健康检查标密SSL配置

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/http/demos

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"http": {

"uri": "/ssl",

"status": "200"

},

"ssl": {

"enable": true,

"ntls": false

}

返回

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Mon, 13 Feb 2023 07:35:27 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.6 增加新的stream,TCP健康检查

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/stcp/demo

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": {

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

},

"ssl": {

"enable": false

}

}

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:06:24 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.7 增加新的stream,UDP健康检查

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/sudp/demo

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": {

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

},

"ssl": {

"enable": false

}

}

返回值

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Fri, 10 Feb 2023 13:06:24 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.8 http健康检查国密SSL配置

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/http/demos

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"http": {

"uri": "/gmssl",

"status": "200"

},

"ssl": {

"enable": true,

"ntls": true,

"ciphers":"ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS"

}

返回

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Mon, 13 Feb 2023 07:35:27 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.9 stream健康检查标密SSL配置

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/stcp/demos

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": {

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

},

"ssl": {

"enable": true,

"ntls": false

}

返回

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Mon, 13 Feb 2023 07:35:27 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.10 stream健康检查国密SSL配置

请求

HTTP

POST http://127.0.0.1:8081/hc/1/hc/stcp/demos

Content-Type: application/json

{

"interval": "3s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": {

"send": "zhao\\x6B\\x61\\x6E\\x67", /* 期望发送的文本 */

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you" /* 期望收到的文本 */

},

"ssl": {

"enable": true,

"ntls": true,

"ciphers":"ECC-SM2-SM4-CBC-SM3:ECDHE-SM2-WITH-SM4-SM3:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-SHA:AES128-GCM-SHA256:AES128-SHA256:AES128-SHA:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-SHA384:ECDHE-RSA-AES256-SHA:AES256-GCM-SHA384:AES256-SHA256:AES256-SHA:ECDHE-RSA-AES128-SHA256:!aNULL:!eNULL:!RC4:!EXPORT:!DES:!3DES:!MD5:!DSS:!PKS"

}

}

返回

HTTP

HTTP/1.1 200 OK

Server: njet/1.23.1

Date: Mon, 13 Feb 2023 07:35:27 GMT

Content-Type: application/json

Content-Length: 37

Connection: keep-alive

{

"code": 0,

"msg": "success"

}

3.6.5.11 http健康检查(增加visit_interval字段)

请求

curl -X 'POST' \

'http://192.168.40.158:8081/api/v1/hc/HTTP/demo' \

-H 'accept: application/json' \

-H 'Content-Type: application/json' \

-d ' { "interval": "10s",

"visit_interval": "5s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"http": {

"uri": "/",

"status": "200 204"

}

}'

返回:

{

"code": 0,

"msg": "success"

}

3.6.5.12 tcp健康检查(增加visit_interval字段)

curl -X 'POST' \

'http://192.168.40.158:8081/api/v1/hc/stcp/demo' \

-H 'accept: application/json' \

-H 'Content-Type: application/json' \

-d '{

"interval": "10s",

"visit_interval": "5s",

"jitter": "1s",

"timeout": "10s",

"passes": 2,

"fails": 1,

"stream": {

"send": "zhao\\x6B\\x61\\x6E\\x67",

"expect": "\\x74\\x68\\x61\\x6E\\x6B\\x20you"

}

}'

返回:

{

"code": 0,

"msg": "success"

}

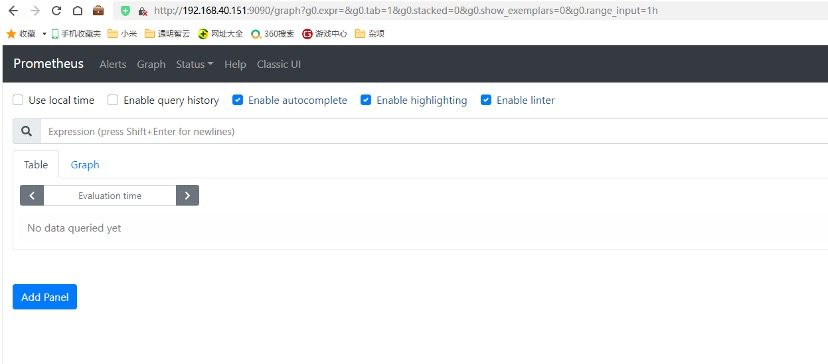

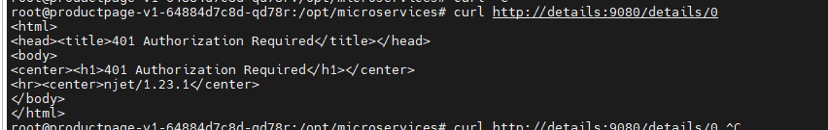

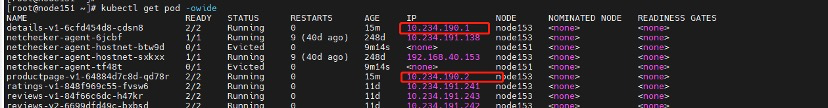

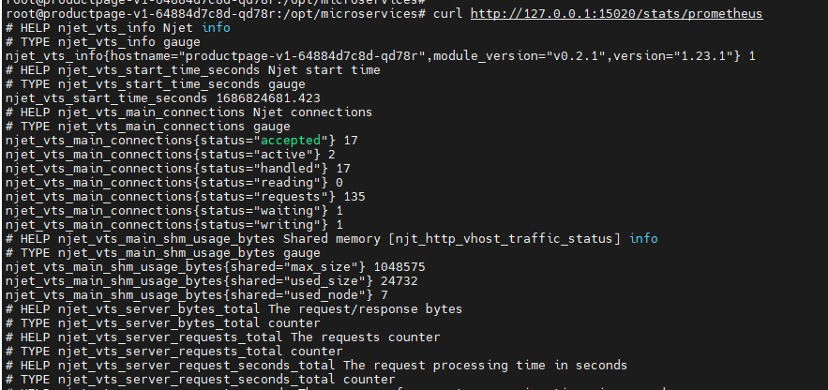

3.7 metrics

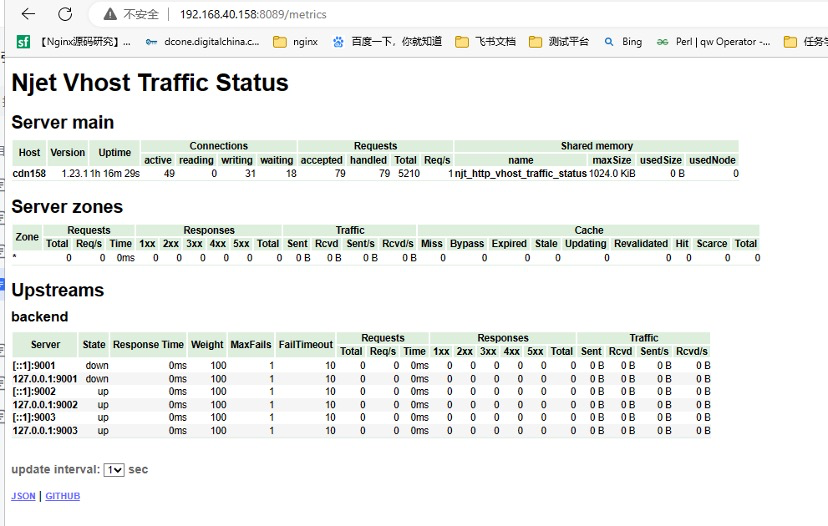

3.7.1 功能介绍

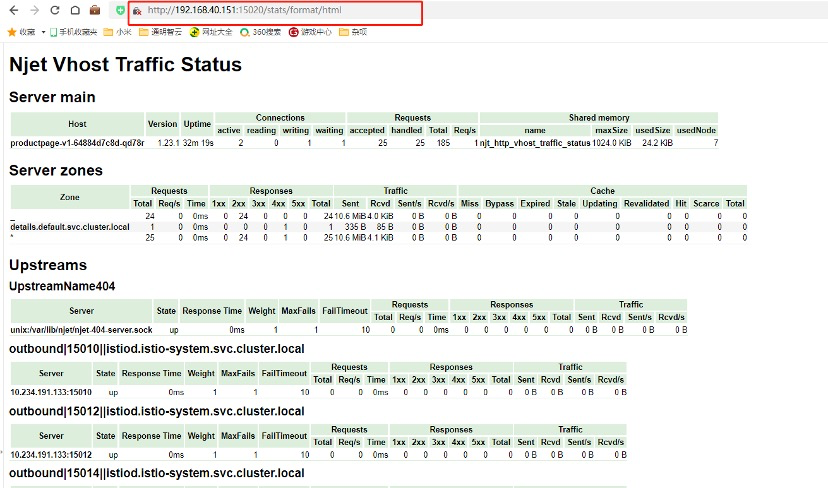

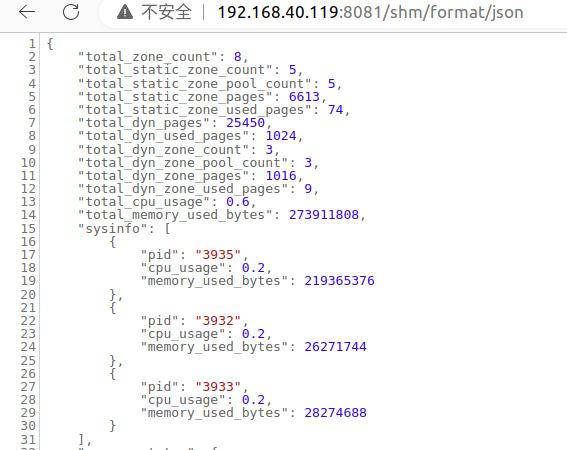

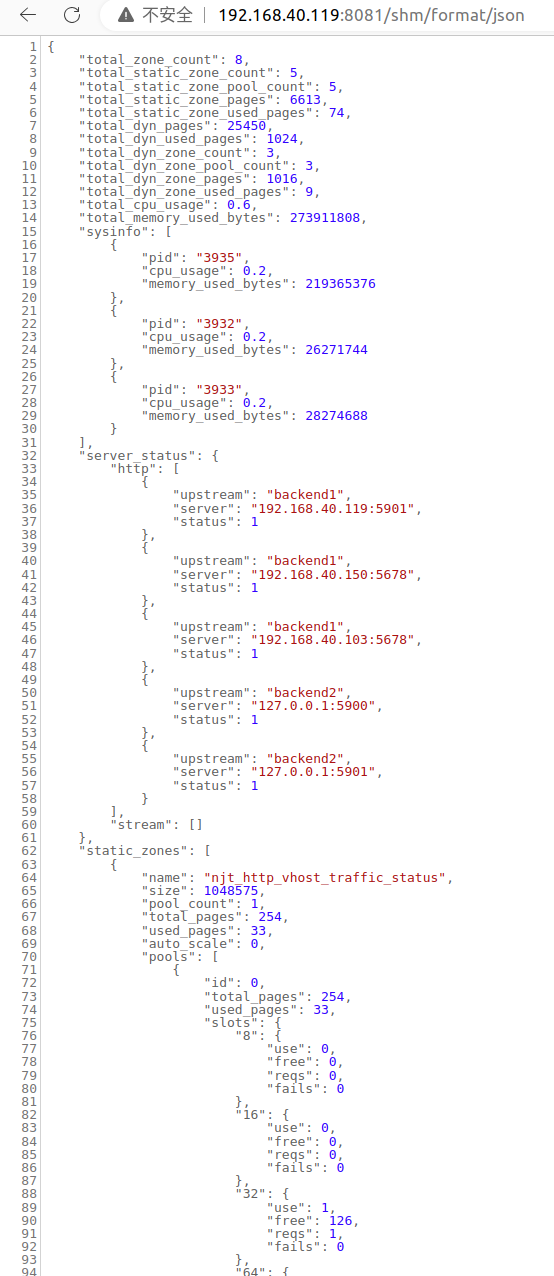

提供对虚拟主机状态信息的访问。包含当前状态、服务器、上游、缓存等信息。

首先,指令 vhost_traffic_status_zone 是必需的, 然后如果指令 vhost_traffic_status_display 设置后,可按如下方式访问:

/status/format/json

○ 如果您要求 /status/format/json,将使用包含当前活动数据的 JSON 文档进行响应,以便在实时仪表板和第三方监视工具中使用。

○ /status/format/jsonp

▪ 如果您要求 /status/format/jsonp,将使用包含当前活动数据的 JSONP 回调函数进行响应,以便在实时仪表板和第三方监视工具中使用。

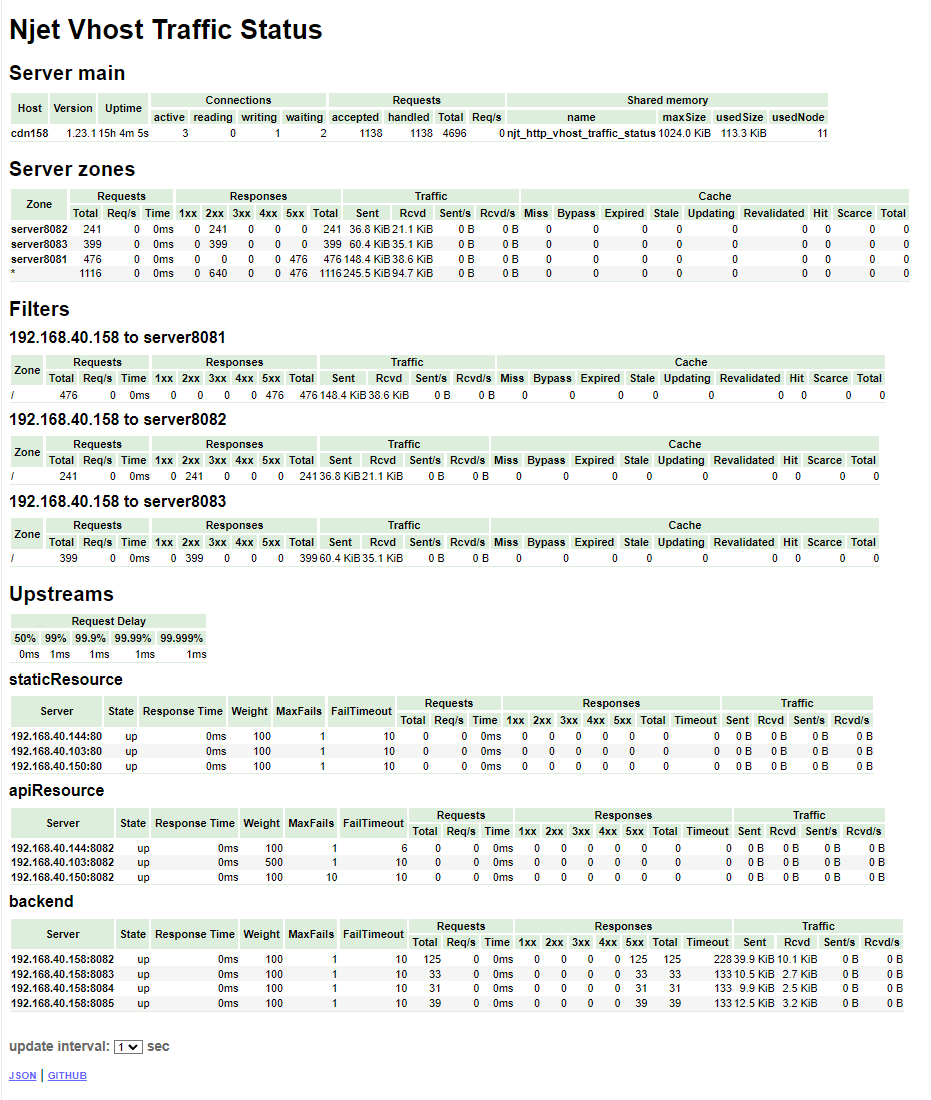

○ /status/format/prometheus

▪ 如果您要求 /status/format/prometheus,将响应 prometheus 格式,包含当前活动数据的文档。

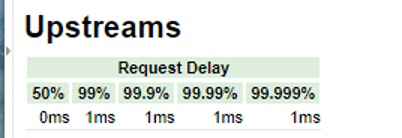

○ vts新指标 统计从收到client请求第一个字节到proxy送给上游服务器前这段时间的百分位数,包括50%, 99%, 99.9%, 99.99%, 99.999%这些百分位的请求延时。具体含义如下:

“p50reqdelayMsecr”: 0, 50%的请求时间延迟应该是0ms(50%的请求应该比给定的延迟更快.换句话说,只允许1%的请求更慢.)

“p99reqdelayMsecr”: 1, 99%的请求时间延迟应该是1ms

“p999reqdelayMsecr”: 1, 99.9%的请求时间延迟应该是1ms

“p9999reqdelayMsecr”: 1, 99.99%的请求时间延迟应该是1ms “p99999reqdelayMsecr”: 1, 99.999%的请求时间延迟应该是1ms

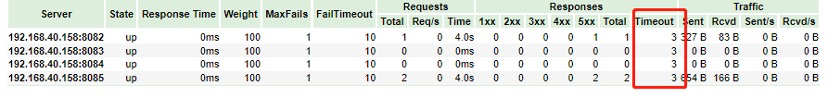

• 统计上游服务器的超时次数 :依赖于反向代理的业务处理,在反向代理的过程中,会选择一个上游服务器处理client的请求。

当超时发生后反向代理会记录这种情况,并尝试选择下一个上游服务器进行处理并记录处理情况。vts新增的 该指标,是把反向代理过程中尝试过的上游服务器的超时次数进行统计,展现给用户。在上图所示中,会记录两个超时次数。对应于error.log中的upstream timed out 。

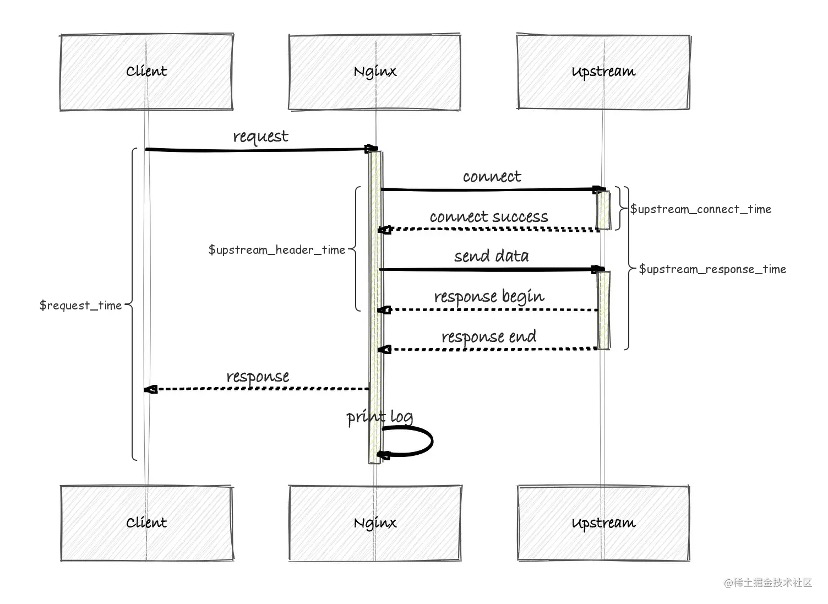

3.7.1.1 新指标时间延迟百分位数设计到的知识

计算时间延迟设计到日志时间变量:

$request_time:从发起请求的客户端获取到第一个字节开始,到返回给客户端最后一个字节后,日志写入文件所经过的时间。单位为秒。

$upstream_connect_time:从与上游服务开始建立连接,到连接建立成功,所经过的时间。单位为秒。

$upstream_header_time:从与上游服务开始建立连接,到接收到响应返回头的第一个字节,所经过的时间。单位为秒。

$upstream_response_time:从与上游服务开始建立连接,到接收完响应返回的最后一个字节,所经过的时间。单位为秒。

结合以上释义,便可得到时序图:

从上图中可以得出时间延迟的计算方法为:

时间延迟=$request_time -$upstream_response_time + $upstream_connect_time';

测试时需要设置log_format aaaa ‘$request_time $upstream_response_time $upstream_connect_time’和

access_log logs/access.log aaaa;两个指令获得$request_time 、$upstream_response_time和 $upstream_connect_time。从access.log 文件中获取这上述提到的3个时间:$request_time,$upstream_response_time,$upstream_connect_time。

测试步骤:

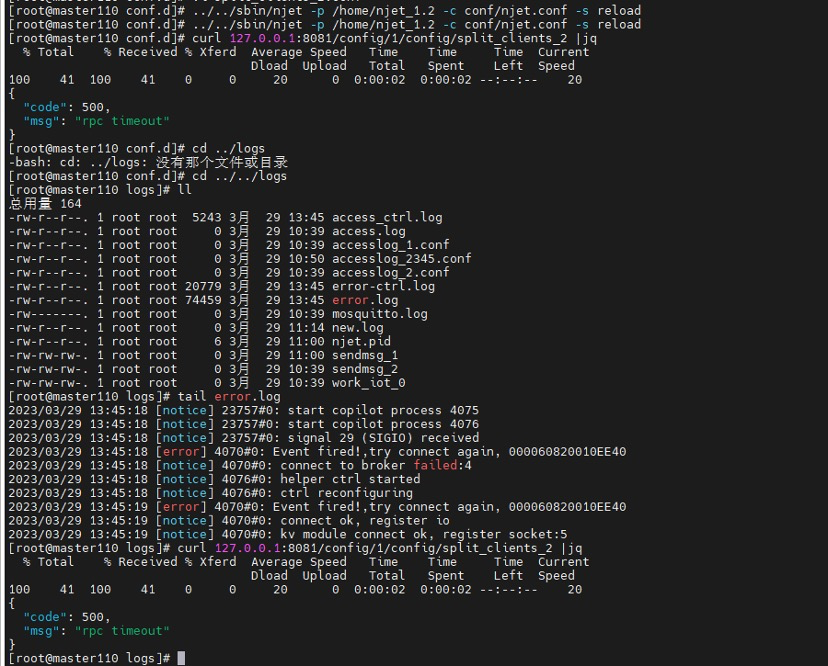

①njet.conf

Bash

helper broker modules/njt_helper_broker_module.so

conf/mqtt.conf;

helper ctrl modules/njt_helper_ctrl_module.so

conf/ctrl.conf;

load_module modules/njt_http_split_clients_2_module.so;

load_module modules/njt_agent_dynlog_module.so;

load_module modules/njt_http_location_module.so;

load_module modules/njt_http_dyn_bwlist_module.so;

load_module modules/njt_http_lua_module.so;

load_module modules/njt_dyn_ssl_module.so;

load_module modules/njt_http_vtsc_module.so;

cluster_name helper;

node_name node1;

worker_processes auto;

error_log logs/error.log info;

pid logs/njet.pid;

events {

worker_connections 1024;

}

http {

dyn_kv_conf conf/iot-work.conf;

include mime.types;

include conf.d/*.conf;

log_format aaaa '$request_time $upstream_response_time $upstream_connect_time';

# log_format aaaa '"request_time:$request_time upstream_response_time:$upstream_response_time upstream_connect_time:$upstream_connect_time"'

# '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

access_log logs/access.log aaaa;

vhost_traffic_status_zone;

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

variables_hash_max_size 2048;

proxy_read_timeout 1;

proxy_cache_path cache1 levels=1:2 keys_zone=cache1:20m max_size=2g inactive=1m use_temp_path=off;

proxy_cache_valid any 10m ;

proxy_cache_revalidate on;

proxy_cache_lock on;

proxy_cache_key $scheme$host$request_uri$slice_range;

map $request_method $purge_method{

PURGE 1;

default 0;

}

upstream staticResource {

server 192.168.40.144;

server 192.168.40.103;

server 192.168.40.150;

}

server {

listen 7111;

server_name server7111;

location ~ .*\.(gif|jpg|jpeg|png|rar|html|txt|mp3|mp4)$ {

#$upstream_cache_status表示资源缓存的状态,有HIT MISS EXPIRED三种状态

add_header X-Cache $upstream_cache_status;

#proxy_cache_bypass $uri !='txt1.txt';

# proxy_cache_bypass $uri !='png1.png';

proxy_pass http://staticResource;

#proxy_cache cache1;

}

}

upstream apiResource {

server 192.168.40.144:8082 fail_timeout=6s;

server 192.168.40.103:8082 weight=5;

server 192.168.40.150:8082 max_fails=10;

}

upstream backend {

server 192.168.40.158:8082 ;

}

server {

listen 8081;

server_name server8081;

location / {

proxy_pass http://backend;

}

}

server {

listen 8082;

server_name server8082;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8093;

server_name server8093;

location / {

return 200 text8093;

}

}

server {

listen 8094;

server_name server8094;

location / {

return 200 text8094;

}

}

server {

listen 8095;

server_name server8095;

location / {

return 200 text8095;

}

}

server {

listen 8084;

server_name server8084;

location / {

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_pass http://apiResource/;

}

}

server {

listen 8086;

server_name server8086;

location /a {

proxy_pass http://192.168.40.246:9008;

}

location / {

return 200 '<h1>server:8086</h1>';

}

}

}

ctrl.conf

load_module modules/njt_http_sendmsg_module.so;

load_module modules/njt_ctrl_config_api_module.so;

load_module modules/njt_helper_health_check_module.so;

load_module modules/njt_http_upstream_api_module.so;

load_module modules/njt_http_location_api_module.so;

load_module modules/njt_doc_module.so;

load_module modules/njt_http_vtsd_module.so;

load_module modules/njt_http_range_api_module.so;

load_module modules/njt_http_cache_quick_module.so;

cluster_name helper;

node_name node1;

error_log logs/error-ctrl.log info;

events {

worker_connections 1024;

}

http {

dyn_sendmsg_conf conf/iot-ctrl.conf;

config_req_pool_size 1000;

access_log logs/access_ctrl.log combined;

include mime.types;

server {

listen 8089;

location /api {

dyn_module_api;

}

location /doc {

doc_api;

}

location /metrics {

vhost_traffic_status_display;

vhost_traffic_status_display_format html;

}

}

}

②通过postman 发送1000 个请求-采集到的时间放在access.log 里;编写计算$request_time-$upstream_response_time+$upstream_connect_time的时间差值,并统计时间值的数量,判断是否和vts 采集指标一致

Bash

#!/bin/bash

cd /home/njet/test_vtsnew2/logs/test

filename="/home/njet/test_vtsnew2/logs/test/access.log"

awk '{ sum = $1 - $2 + $3; print sum }' $filename >out.log

awk '{a[$1]++}END{for(i in a) print i, a[i]}' out.log

新指标timeout 次数统计:

①njet.conf

Bash

helper broker modules/njt_helper_broker_module.so

conf/mqtt.conf;

helper ctrl modules/njt_helper_ctrl_module.so

conf/ctrl.conf;

load_module modules/njt_http_split_clients_2_module.so;

load_module modules/njt_agent_dynlog_module.so;

load_module modules/njt_http_location_module.so;

load_module modules/njt_http_dyn_bwlist_module.so;

load_module modules/njt_http_lua_module.so;

load_module modules/njt_dyn_ssl_module.so;

load_module modules/njt_http_vtsc_module.so;

cluster_name helper;

node_name node1;

worker_processes auto;

error_log logs/error.log info;

pid logs/njet.pid;

events {

worker_connections 1024;

}

http {

dyn_kv_conf conf/iot-work.conf;

include mime.types;

include conf.d/*.conf;

vhost_traffic_status_zone;

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

variables_hash_max_size 2048;

proxy_cache_path cache1 levels=1:2 keys_zone=cache1:20m max_size=2g inactive=1m use_temp_path=off;

proxy_cache_valid any 10m ;

proxy_cache_revalidate on;

proxy_cache_lock on;

proxy_cache_key $scheme$host$request_uri$slice_range;

map $request_method $purge_method{

PURGE 1;

default 0;

}

upstream staticResource {

server 192.168.40.144;

server 192.168.40.103;

server 192.168.40.150;

}

upstream backend {

server 192.168.40.158:8082;

server 192.168.40.158:8083;

server 192.168.40.158:8084;

server 192.168.40.158:8085;

}

server {

listen 8081;

server_name server8081;

location / {

proxy_pass http://backend;

proxy_next_upstream_timeout 6;

proxy_read_timeout 1;

}

}

server {

listen 8082;

server_name server8082;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8083;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8084;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8085;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

}

main.lua 中配置:

Bash

njt.sleep(2)

--local args,err = njt.req.get_uri_args()

--local k= args["k"]

njt.say("hello world:")

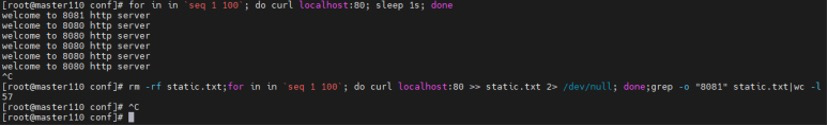

②启动njet 包,每秒发送一次curl 命令,判断timeout 次数是否在增加

Bash

watch -n1 'curl -k http://192.168.40.158:8081/'

3.7.1.2 JSON 示例

{

"hostName": ...,

"moduleVersion": ...,

"njetVersion": ...,

"loadMsec": ...,

"nowMsec": ...,

"connections": {

"active":...,

"reading":...,

"writing":...,

"waiting":...,

"accepted":...,

"handled":...,

"requests":...

},

"sharedZones": {

"name":...,

"maxSize":...,

"usedSize":...,

"usedNode":...

},

"serverZones": {

"...":{

"requestCounter":...,

"inBytes":...,

"outBytes":...,

"responses":{

"1xx":...,

"2xx":...,

"3xx":...,

"4xx":...,

"5xx":...,

"miss":...,

"bypass":...,

"expired":...,

"stale":...,

"updating":...,

"revalidated":...,

"hit":...,

"scarce":...

},

"requestMsecCounter":...,

"requestMsec":...,

"requestMsecs":{

"times":[...],

"msecs":[...]

},

"requestBuckets":{

"msecs":[...],

"counters":[...]

},

}

...

},

"filterZones": {

"...":{

"...":{

"requestCounter":...,

"inBytes":...,

"outBytes":...,

"responses":{

"1xx":...,

"2xx":...,

"3xx":...,

"4xx":...,

"5xx":...,

"miss":...,

"bypass":...,

"expired":...,

"stale":...,

"updating":...,

"revalidated":...,

"hit":...,

"scarce":...

},

"requestMsecCounter":...,

"requestMsec":...,

"requestMsecs":{

"times":[...],

"msecs":[...]

},

"requestBuckets":{

"msecs":[...],

"counters":[...]

},

},

...

},

...

},

"upstreamZones": {

"...":[

{

"server":...,

"requestCounter":...,

"inBytes":...,

"outBytes":...,

"responses":{

"1xx":...,

"2xx":...,

"3xx":...,

"4xx":...,

"5xx":...

},

"requestMsecCounter":...,

"requestMsec":...,

"requestMsecs":{

"times":[...],

"msecs":[...]

},

"requestBuckets":{

"msecs":[...],

"counters":[...]

},

"responseMsecCounter":...,

"responseMsec":...,

"responseMsecs":{

"times":[...],

"msecs":[...]

},

"responseBuckets":{

"msecs":[...],

"counters":[...]

},

"weight":...,

"maxFails":...,

"failTimeout":...,

"backup":...,

"down":...

}

...

],

...

}

"cacheZones": {

"...":{

"maxSize":...,

"usedSize":...,

"inBytes":...,

"outBytes":...,

"responses":{

"miss":...,

"bypass":...,

"expired":...,

"stale":...,

"updating":...,

"revalidated":...,

"hit":...,

"scarce":...

}

},

...

}

}

3.7.1.3 JSON 字段含义

以下含义以 JSON 示例顺序提供:

hostName

主机名

moduleVersion

{Version}(|.dev.{commit})格式的模块版本。

njetVersion

njet版本。

loadMsec

加载过程时间(以毫秒为单位)。

nowMsec

当前时间(毫秒)

connections

active

当前活动客户端连接数。

reading

读取客户端连接的总数。

writing

写入客户端连接的总数。

waiting

等待客户端连接的总数。

accepted

接受的客户端连接总数。

handled

已处理的客户端连接总数。

requests

请求的客户端连接总数。

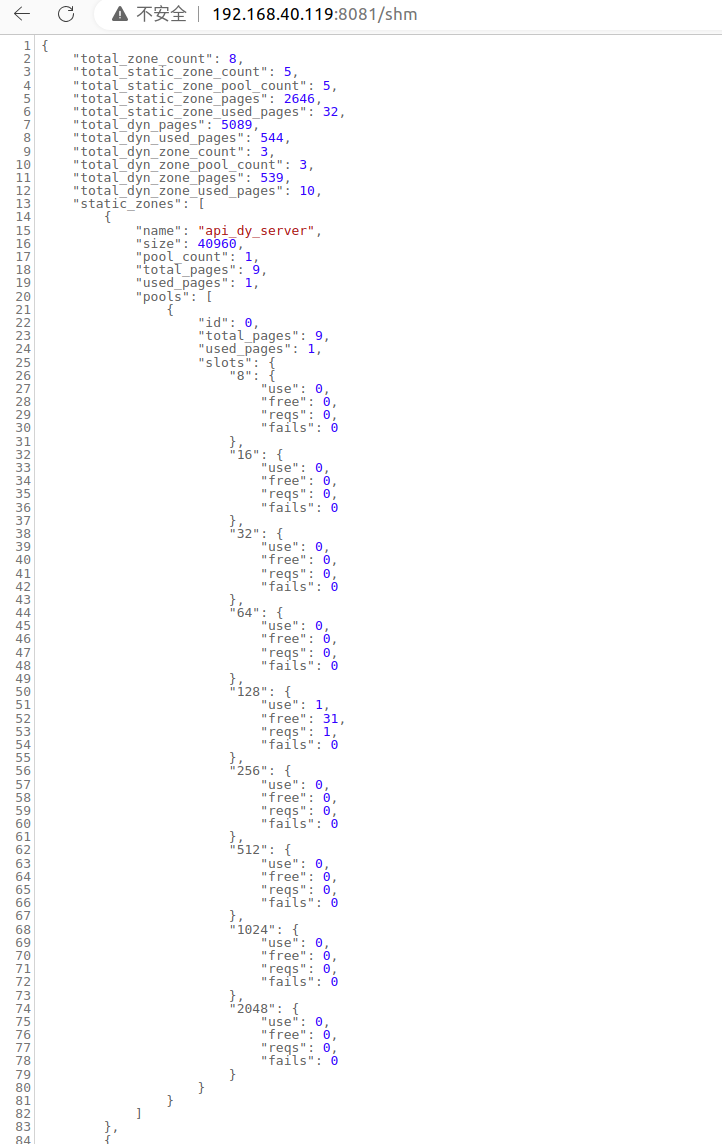

sharedZones

name

在配置中指定的共享内存的名称。(默认值: vhost_traffic_status)

maxSize

在配置中指定的共享内存的最大大小的限制。

usedSize

共享内存的当前大小。

usedNode

共享内存中使用的当前节点数。它可以通过以下公式获得一个节点的大致大小:(usedSize / usedNode)

serverZones

requestCounter

从客户端收到的客户端请求总数。

inBytes

从客户端接收的总字节数。

outBytes

发送到客户端的总字节数。

responses

1xx, 2xx, 3xx, 4xx, 5xx

状态代码为 1xx、2xx、3xx、4xx 和 5xx 的响应数。

miss

cache miss的个数。

bypass

缓存绕过的数量。

expired

缓存过期的数量。

stale

缓存过时的数量。

updating

缓存更新的次数。

revalidated

重新验证的缓存数。

hit

缓存命中数。

scarce

缓存不足的数量。

requestMsecCounter

累积请求处理时间的次数(以毫秒为单位)。

requestMsec

请求处理时间的平均时间(以毫秒为单位)。

requestMsecs

times

请求处理时间以毫秒为单位。

msecs

请求处理时间(包括上游),以毫秒为单位。

requestBuckets

msecs

由vhost_traffic_status_histogram_buckets指令设置的柱状图的桶值。

counters

每个存储桶值大于或等于请求处理时间的累积值。

filterZones

它提供了与serverzone相同的字段,只是包含了组名。

upstreamZones

server

服务器的地址。

requestCounter

转发到此服务器的客户端连接总数。

inBytes

从此服务器接收的总字节数。

outBytes

发送到此服务器的总字节数。

responses

1xx, 2xx, 3xx, 4xx, 5xx

状态代码为 1xx、2xx、3xx、4xx 和 5xx 的响应数。

requestMsecCounter

包括上游在内的累计请求处理时间数(以毫秒为单位)。

requestMsec

请求处理时间(包括上游)的平均时间(以毫秒为单位)。

requestMsecs

times

请求处理时间以毫秒为单位。

msecs

请求处理时间(包括上游),以毫秒为单位。

requestBuckets

msecs

由vhost_traffic_status_histogram_buckets指令设置的柱状图的桶值。

counters

每个存储桶值大于或等于请求处理时间(包括上游)的累积值。

responseMsecCounter

累积的仅上游响应处理时间的数量,以毫秒为单位。

responseMsec

仅上游响应处理时间的平均值(以毫秒为单位)。

responseMsecs

times

请求处理时间以毫秒为单位。

msecs

唯一的上游响应处理时间(以毫秒为单位)。

responseBuckets

msecs

由vhost_traffic_status_histogram_buckets指令设置的柱状图的桶值。

counters

每个存储桶值大于或等于唯一上游响应处理时间的累积值。

weight

当前服务器设置的权重

maxFails

服务器当前max_fails设置。

failTimeout

服务器当前fail_timeout设置。

backup

服务器当前备份设置。

down

服务器当前down设置。基本上,这只是一个标记ngx_http_upstream_module的服务器关闭(例如。服务器backend3.example.com关闭),而不是实际的上游服务器状态。如果你启用了upstream zone指令,它将改变为实际状态。

cacheZones

maxSize

在配置中指定的缓存的最大大小的限制。如果proxy_cache_path指令中的max_size未指定,则默认分配系统依赖值NGX_MAX_OFF_T_VALUE

usedSize

缓存的当前大小。这个值取自njet,就像上面的maxSize值一样。

inBytes

从缓存接收的总字节数。

outBytes

从缓存发送的总字节数。

responses

miss

缓存未命中数。

bypass

缓存绕过的数量。

expired

缓存过期的数量。

stale

缓存过时的数量。

updating

缓存更新的次数。

revalidated

重新验证的缓存数。

hit

缓存命中数。

scarce

缓存不足的数量。

3.7.2 功能展示

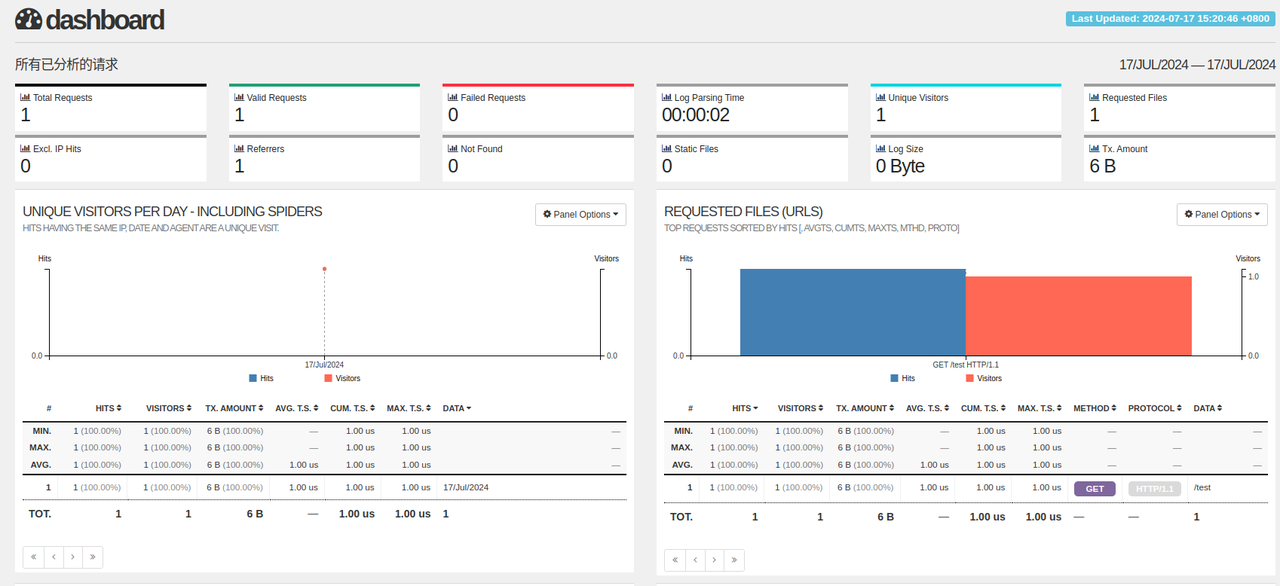

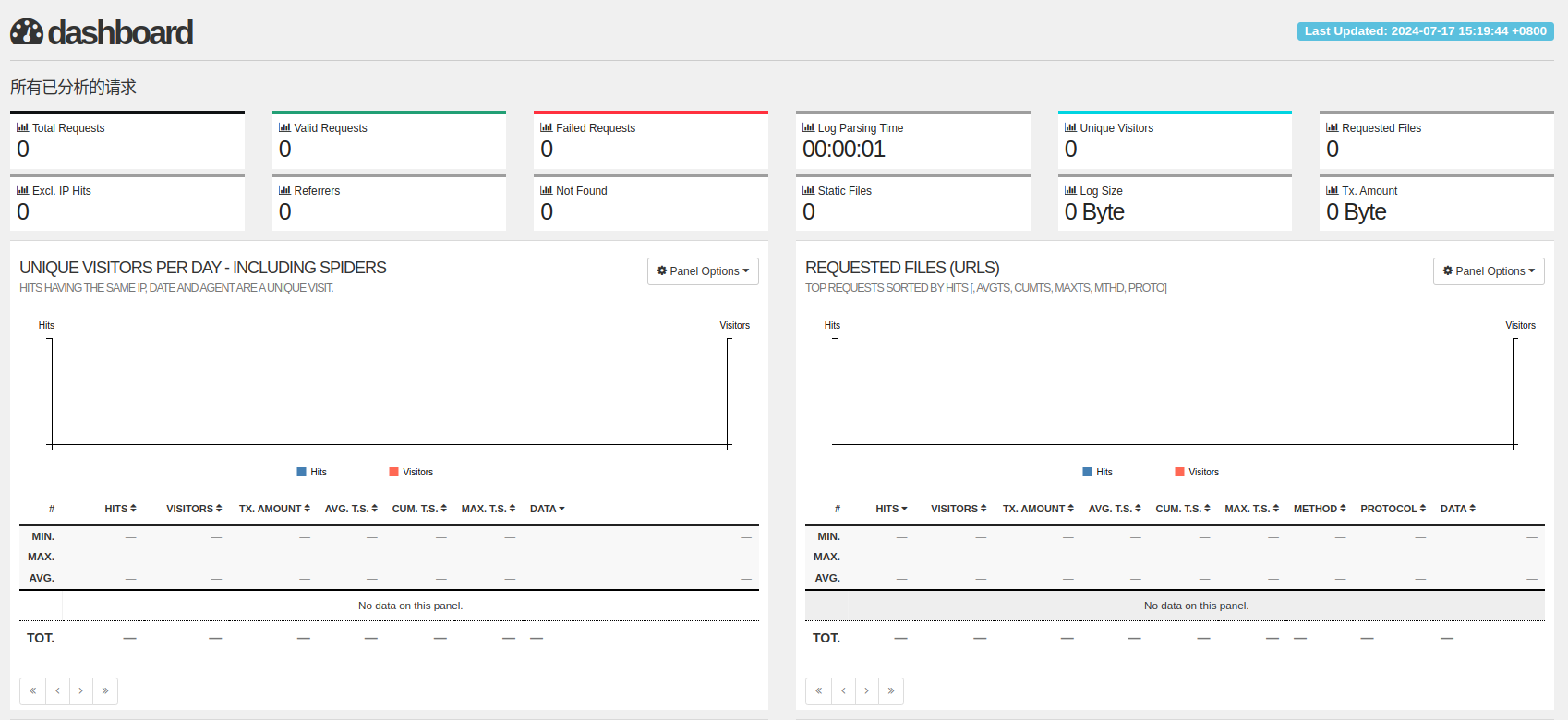

vts监控页面:

增加新指标后:

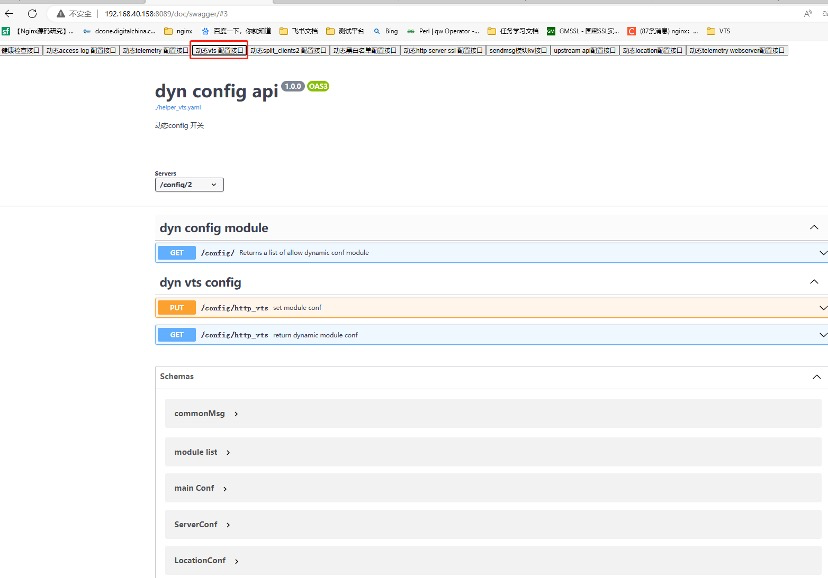

swagger页面:

3.7.3 配置说明

3.7.3.1 vhost_traffic_status

| - | - |

|---|---|

| 语法 | vhost_traffic_status <on|off> |

| 默认 | 关闭 |

| 上下文 | http、server、location |

| 配置 | 数据面 |

| |

描述: 启用或禁用数据面统计指定上下文内性能指标数据。如果设置 了vhost_traffic_status_zone 指令,将自动启用。

3.7.3.2 vhost_traffic_status_zone

| - | - |

|---|---|

| 语法 | vhost_traffic_status_zone [shared:name:size] |

| 默认 | shared:vhost_traffic_status:1m |

| 上下文 | http |

| 配置 | 数据面 |

描述: 为数据面共享内存区域设置参数,该区域将保留各种键的状态。缓存在所有工作进程之间共享。

在大多数情况下,njet-module-vts使用的共享内存大小不会增加太多。当使用vhost_traffic_status_filter_by_set_key指令时,共享内存大小会增加很多,但如果过滤器的键是固定的(例如。国家代码的总数约为240),则不会持续增加。

如果使用vhost_traffic_status_filter_by_set_key指令,设置如下:

○ 默认设置为上限32M的共享内存大小。(vhost_traffic_status_zone shared:vhost_traffic_status:32 m)

○ 如果在error_log中打印出:(“ngx_slab_alloc() failed: no memory in vhost_traffic_status_zone”),则增加到大于(usedSize * 2)。

3.7.3.3 vhost_traffic_status_filter_by_set_key

| - | - |

|---|---|

| 语法 | vhost_traffic_status_filter_by_set_key key [name] |

| 默认 | - |

| 上下文 | http |

| 配置 | 数据面 |

| 描述: 通过用户定义的变量作为展示的维度。key和name可以使用变量,如$host、$server_name等 |

示例如下:

http{

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

...

}

3.7.3.4 vhost_traffic_status_display

|

- |

- |

|

语法 |

vhost_traffic_status_display |

|

默认 |

- |

|

上下文 |

location |

|

配置 |

控制面 |

描述: 启用或禁用控制面显示处理程序。

3.7.3.5 vhost_traffic_status_display_format

|

- |

- |

|

语法 |

vhost_traffic_status_display_format <json|html|jsonp|prometheus> |

|

默认 |

json |

|

上下文 |

location |

|

配置 |

控制面 |

描述: 设置控制面数据输出的格式。

○ 如果设置 json,将使用 JSON 格式进行响应;

○ 如果设置 html,将使用 HTML 中的内置实时仪表板进行响应;

○ 如果设置 jsonp,将使用 JSONP 回调函数(默认: ngx_http_vhost_traffic_status_jsonp_callback);

○ 如果设置 prometheus,将响应 prometheus格式的数据。

3.7.3.6 配置示例

3.7.3.6.1 控制面

load_module modules/njt_http_vtsc_module.so;

error_log logs/error-ctrl.log info;

events {

....

}

http {

access_log logs/access-ctrl.log combined;

server {

listen 8081;

location /metrics {

vhost_traffic_status_display;

vhost_traffic_status_display_format html;

}

}

}

3.7.3.6.2 数据面

load_module modules/njt_http_vtsd_module.so;

helper broker modules/njt_helper_broker_module.so conf/mqtt.conf;

helper ctrl modules/njt_helper_ctrl_module.so conf/ctrl.conf;

error_log logs/error.log info;

events {

....

}

http {

vhost_traffic_status_zone;

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

....

....

}

3.7.4 动态开关

vts模块可以通过动态配置接口实现对是否统计及统计指标的动态配置,详见:动态开关功能

3.7.5 接口消息返回提示

3.7.5.1 查询

第一种方法:

curl -X 'GET' \

'http://127.0.0.1:8089/api/v1/config/http_vts' \

-H 'accept: application/json'

3.7.5.2 配置修改

curl -X PUT -d @input.json http://127.0.0.1:8089/api/v1/config/http_vts >out.json

3.7.5.3 结果

get 返回结果示例:

{

"vhost_traffic_status_filter_by_set_key":"\"$request_uri\" \"$server_name\"",

"servers":[

{

"listens":[

"0.0.0.0:8082"

],

"serverNames":[

"localhost"

],

"locations":[

{

"location":"/",

"vhost_traffic_status":false

}

]

},

{

"listens":[

"0.0.0.0:9001"

],

"serverNames":[

"localhost"

],

"locations":[

{

"location":"/",

"vhost_traffic_status":true

},

{

"location":"= /notexist",

"vhost_traffic_status":true

}

]

},

{

"listens":[

"0.0.0.0:9002"

],

"serverNames":[

"localhost"

],

"locations":[

{

"location":"/",

"vhost_traffic_status":true

},

{

"location":"= /50x.html",

"vhost_traffic_status":true

}

]

},

{

"listens":[

"0.0.0.0:9003"

],

"serverNames":[

"localhost"

],

"locations":[

{

"location":"/",

"vhost_traffic_status":true

},

{

"location":"= /50x.html",

"vhost_traffic_status":true

}

]

}

]

}

Post 返回结果示例:

{

"code": 0,

"msg": "success"

}

3.7.5.4 **新指标配置时间延迟百分位数(**njet.conf)

Bash

helper broker modules/njt_helper_broker_module.so

conf/mqtt.conf;

helper ctrl modules/njt_helper_ctrl_module.so

conf/ctrl.conf;

load_module modules/njt_http_split_clients_2_module.so;

load_module modules/njt_agent_dynlog_module.so;

load_module modules/njt_http_location_module.so;

load_module modules/njt_http_dyn_bwlist_module.so;

load_module modules/njt_http_lua_module.so;

load_module modules/njt_dyn_ssl_module.so;

load_module modules/njt_http_vtsc_module.so;

cluster_name helper;

node_name node1;

worker_processes auto;

error_log logs/error.log info;

pid logs/njet.pid;

events {

worker_connections 1024;

}

http {

dyn_kv_conf conf/iot-work.conf;

include mime.types;

include conf.d/*.conf;

log_format aaaa '$request_time $upstream_response_time $upstream_connect_time';

# log_format aaaa '"request_time:$request_time upstream_response_time:$upstream_response_time upstream_connect_time:$upstream_connect_time"'

# '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

access_log logs/access.log aaaa;

vhost_traffic_status_zone;

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

variables_hash_max_size 2048;

proxy_read_timeout 1;

proxy_cache_path cache1 levels=1:2 keys_zone=cache1:20m max_size=2g inactive=1m use_temp_path=off;

proxy_cache_valid any 10m ;

proxy_cache_revalidate on;

proxy_cache_lock on;

proxy_cache_key $scheme$host$request_uri$slice_range;

map $request_method $purge_method{

PURGE 1;

default 0;

}

upstream staticResource {

server 192.168.40.144;

server 192.168.40.103;

server 192.168.40.150;

}

server {

listen 7111;

server_name server7111;

location ~ .*\.(gif|jpg|jpeg|png|rar|html|txt|mp3|mp4)$ {

#$upstream_cache_status表示资源缓存的状态,有HIT MISS EXPIRED三种状态

add_header X-Cache $upstream_cache_status;

#proxy_cache_bypass $uri !='txt1.txt';

# proxy_cache_bypass $uri !='png1.png';

proxy_pass http://staticResource;

#proxy_cache cache1;

}

}

upstream apiResource {

server 192.168.40.144:8082 fail_timeout=6s;

server 192.168.40.103:8082 weight=5;

server 192.168.40.150:8082 max_fails=10;

}

upstream backend {

server 192.168.40.158:8082 ;

}

server {

listen 8081;

server_name server8081;

location / {

proxy_pass http://backend;

}

}

server {

listen 8082;

server_name server8082;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8093;

server_name server8093;

location / {

return 200 text8093;

}

}

server {

listen 8094;

server_name server8094;

location / {

return 200 text8094;

}

}

server {

listen 8095;

server_name server8095;

location / {

return 200 text8095;

}

}

server {

listen 8084;

server_name server8084;

location / {

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_pass http://apiResource/;

}

}

server {

listen 8086;

server_name server8086;

location /a {

proxy_pass http://192.168.40.246:9008;

}

location / {

return 200 '<h1>server:8086</h1>';

}

}

}

3.7.5.5 结果

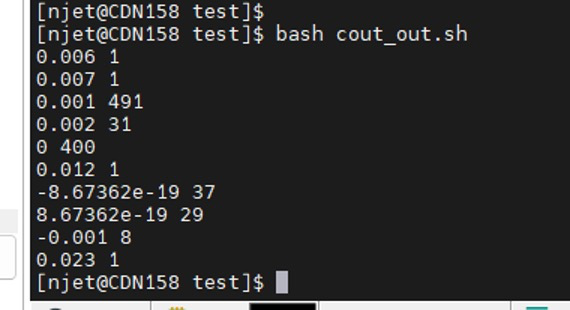

通过postman 发送1000个请求后统计的时间延迟结果如下:

Bash

cd /home/njet/test_vtsnew2/logs/test

filename="/home/njet/test_vtsnew2/logs/test/access.log"

awk '{ sum = $1 - $2 + $3; print sum }' $filename >out.log

awk '{a[$1]++}END{for(i in a) print i, a[i]}' out.log

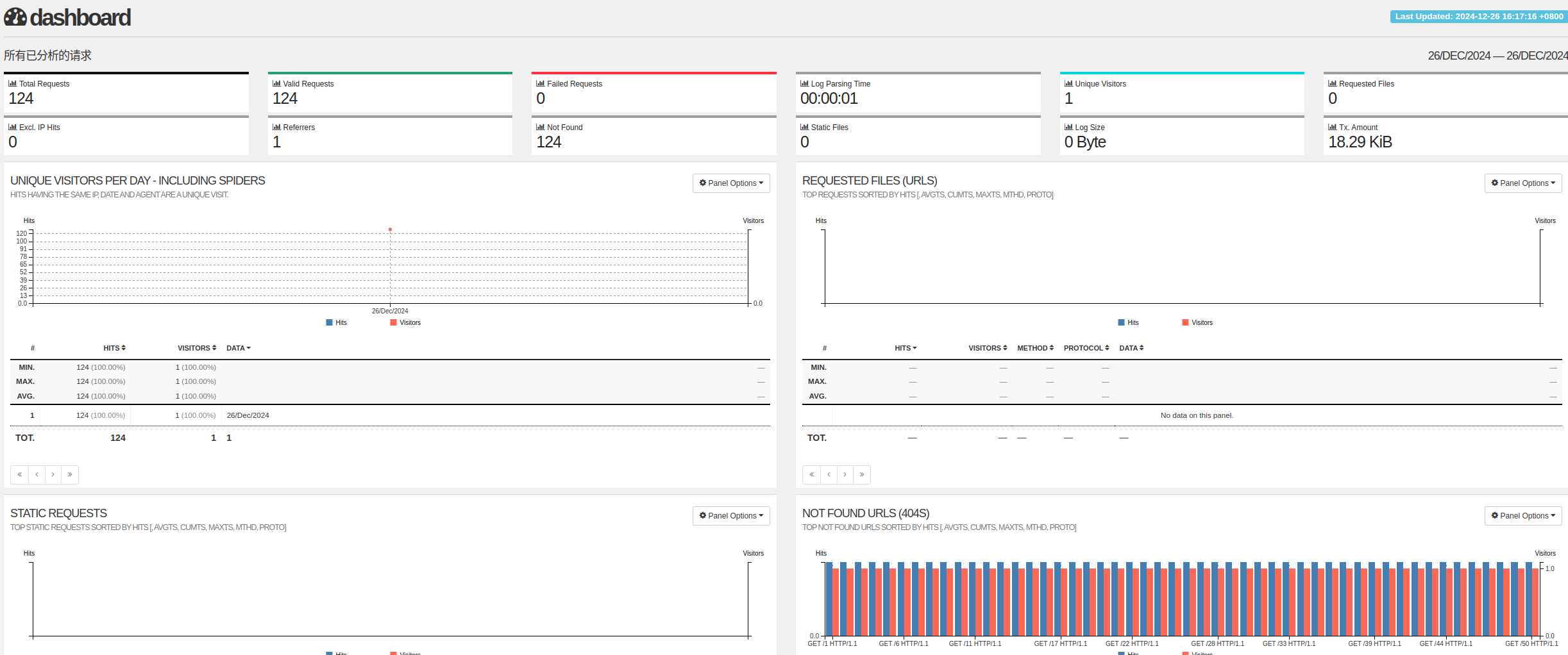

结果截图:

Vts 采集页面展示:

3.7.5.6 新指标配置timeout**次数统计(**njet.conf)

Bash

helper broker modules/njt_helper_broker_module.so

conf/mqtt.conf;

helper ctrl modules/njt_helper_ctrl_module.so

conf/ctrl.conf;

load_module modules/njt_http_split_clients_2_module.so;

load_module modules/njt_agent_dynlog_module.so;

load_module modules/njt_http_location_module.so;

load_module modules/njt_http_dyn_bwlist_module.so;

load_module modules/njt_http_lua_module.so;

load_module modules/njt_dyn_ssl_module.so;

load_module modules/njt_http_vtsc_module.so;

cluster_name helper;

node_name node1;

worker_processes auto;

error_log logs/error.log info;

pid logs/njet.pid;

events {

worker_connections 1024;

}

http {

dyn_kv_conf conf/iot-work.conf;

include mime.types;

include conf.d/*.conf;

vhost_traffic_status_zone;

vhost_traffic_status_filter_by_set_key $request_uri "$realip_remote_addr to $server_name";

variables_hash_max_size 2048;

proxy_cache_path cache1 levels=1:2 keys_zone=cache1:20m max_size=2g inactive=1m use_temp_path=off;

proxy_cache_valid any 10m ;

proxy_cache_revalidate on;

proxy_cache_lock on;

proxy_cache_key $scheme$host$request_uri$slice_range;

map $request_method $purge_method{

PURGE 1;

default 0;

}

upstream staticResource {

server 192.168.40.144;

server 192.168.40.103;

server 192.168.40.150;

}

upstream backend {

server 192.168.40.158:8082;

server 192.168.40.158:8083;

server 192.168.40.158:8084;

server 192.168.40.158:8085;

}

server {

listen 8081;

server_name server8081;

location / {

proxy_pass http://backend;

proxy_next_upstream_timeout 6;

proxy_read_timeout 1;

}

}

server {

listen 8082;

server_name server8082;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8083;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8084;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

server {

listen 8085;

server_name server8083;

access_log /home/njet/test_vtsnew2/logs/8082.log;

location / {

content_by_lua_file main.lua;

}

}

}

3.7.5.7 结果

Bash

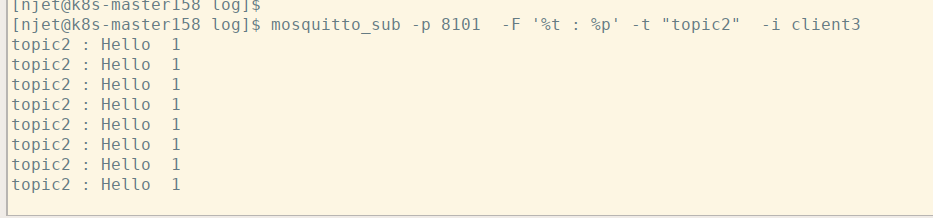

通过 watch -n1 'curl -k http://192.168.40.158:8081/' 这个指令每秒访问一次,查看vts界面中timeout 次数统计是否正确

3.7.6 API接口ACL控制

该模块可以设置acl控制,具体设置方法参考3.25章节描述。

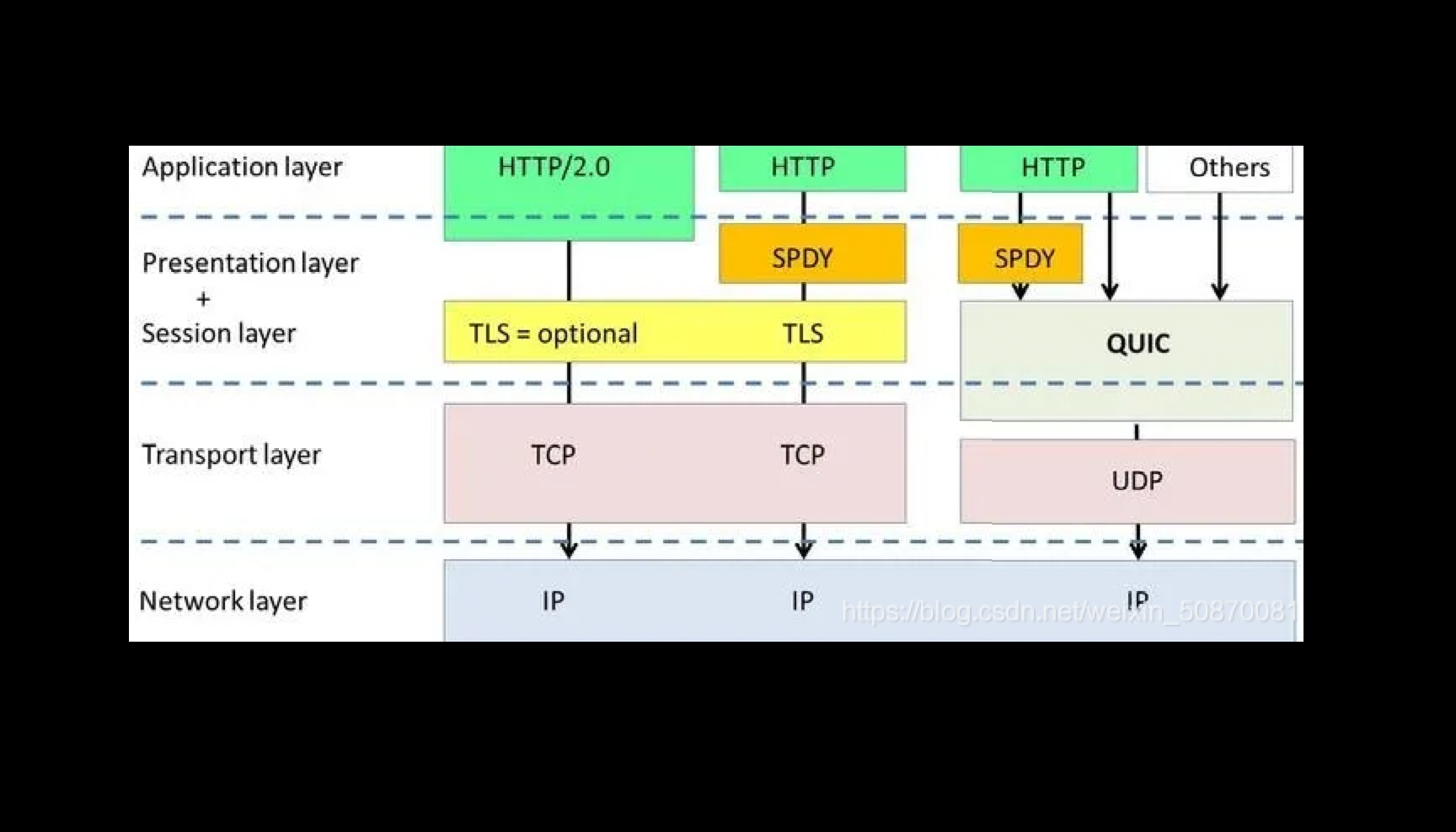

3.8 telemetry功能

3.8.1 介绍

3.8.1.1 什么是OpenTelemetry?

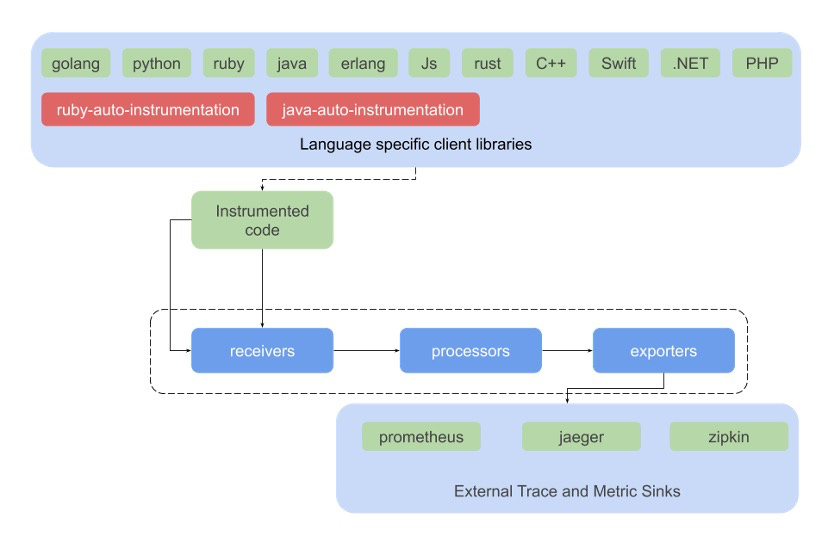

OpenTelemetry合并了OpenTracing和OpenCensus项目,提供了一组API和库来标准化遥测数据的采集和传输。OpenTelemetry提供了一个安全,厂商中立的工具,这样就可以按照需要将数据发往不同的后端。

OpenTelemetry项目由如下组件构成:

○ 推动在所有项目中使用一致的规范

○ 基于规范的,包含接口和实现的APIs

○ 不同语言的SDK(APIs的实现),如 Java, Python, Go, Erlang等

○ Exporters:可以将数据发往一个选择的后端

○ Collectors:厂商中立的实现,用于处理和导出遥测数据

3.8.1.2 术语

○ Traces:记录经过分布式系统的请求活动,一个trace是spans的有向无环图

○ Spans:一个trace中表示一个命名的,基于时间的操作。Spans嵌套形成trace树。每个trace包含一个根span,描述了端到端的延迟,其子操作也可能拥有一个或多个子spans。

○ Metrics:在运行时捕获的关于服务的原始度量数据。Opentelemetry定义的metric instruments(指标工具)如下。Observer支持通过异步API来采集数据,每个采集间隔采集一个数据。

○ Context:一个span包含一个span context,它是一个全局唯一的标识,表示每个span所属的唯一的请求,以及跨服务边界转移trace信息所需的数据。OpenTelemetry 也支持correlation context,它可以包含用户定义的属性。correlation context不是必要的,组件可以选择不携带和存储该信息。

○ Context propagation:表示在不同的服务之间传递上下文信息,通常通过HTTP首部。Context propagation 是 OpenTelemetry 系统的关键功能之一。除了tracing之外,还有一些有趣的用法,如,执行A/B测试。OpenTelemetry支持通过多个协议的Context propagation来避免可能发生的问题,但需要注意的是,在自己的应用中最好使用单一的方法。

3.8.1.3 OpenTelemetry架构

opentelemetry也是个插件式的架构,针对不同的开发语言会有相应的Client组件,叫Instrumenttation,也就是在代码中埋点调用的api/sdk采集telemetry数据

OpenNJet主要集成了分布式服务 telemetry 模块:

分布式服务追踪模块: njt_otel_module.so

3.8.2 分布式服务追踪模块: njt_otel_module.so

3.8.2.1 指令介绍

3.8.2.1.1 opentelemetry

启用或禁用OpenTelemetry (默认为启用)。

○ required: false

○ syntax: opentelemetry on|off

○ block: http, server, location

3.8.2.1.2 opentelemetry_trust_incoming_spans

启用或禁用使用传入请求的spans作为创建请求的父级。(默认值: 启用)。

○ required: false

○ syntax: opentelemetry_trust_incoming_spans on|off

○ block: http, server, location

3.8.2.1.3 opentelemetry_attribute

向 span 添加自定义属性,可以访问 NJet 变量, 如: opentelemetry_attribute “my.user.agent” “$http_user_agent”.

○ required: false

○ syntax: opentelemetry_attribute

○ block: http, server, location

3.8.2.1.4 opentelemetry_config

Exporters, processors

○ required: true

○ syntax: opentelemetry_config /path/to/config.toml

○ block: http

3.8.2.1.5 opentelemetry_operation_name

在启动新的 span 时设置操作名称。

○ required: false

○ syntax: opentelemetry_operation_name

○ block: http, server, location

3.8.2.1.6 opentelemetry_propagate

启用分布式跟踪头的传播, e.g. traceparent。

当没有给出父跟踪时,将启动新的跟踪。默认的传播器是 W3C。

应用的继承规则与proxy_set_header相同,这意味着当且仅当在较低的配置级别上没有定义proxy_set_header 指令时,才在当前配置级别应用该指令。

○ required: false

○ syntax: opentelemetry_propagate or opentelemetry_propagate b3

○ block: http, server, location

3.8.2.1.7 opentelemetry_capture_headers

允许捕获请求和响应头(默认值: 禁用)。

○ required: false

○ syntax: opentelemetry_capture_headers on|off

○ block: http, server, location

3.8.2.1.8 opentelemetry_sensitive_header_names

对于名称匹配给定正则表达式(不区分大小写)的所有头,将捕获的头值设置为[REDACTED]。

○ required: false

○ syntax: opentelemetry_sensitive_header_names

○ block: http, server, location

3.8.2.1.9 opentelemetry_sensitive_header_values

将捕获的头值设置为[REDACTED],用于所有与给定正则表达式匹配的头(不区分大小写)。

○ required: false

○ syntax: opentelemetry_sensitive_header_values

○ block: http, server, location

3.8.2.1.10 opentelemetry_ignore_paths

不会为匹配给定正则表达式的 URI 创建 span (不区分大小写)。

○ required: false

○ syntax: opentelemetry_ignore_paths

○ block: http, server, location

3.8.2.2 NJet.conf 配置

Bash

#user root;

worker_processes 1;

daemon off;

#master_process on;

error_log /home/njet/clbtest/logs/error.log debug;

pid /home/njet/clbtest/njet.pid;

#load_module /root/project/telemetry/opentelemetry-cpp-contrib-main/instrumentation/njet/build/otel_ngx_module.so;

load_module /home/njet/modules/njt_otel_module.so;

events {

worker_connections 1024;

}

http {

opentelemetry_config /home/njet/clbtest/conf/otel-njet.toml;

opentelemetry off;

upstream http1{

server 192.168.40.139:9002;

#server 192.168.40.136:8082;

}

server {

listen 8081;

server_name otel_example;

location = / {

opentelemetry on;

opentelemetry_operation_name my_example_backend;

opentelemetry_propagate;

proxy_pass http://http1;

}

location = /b3 {

opentelemetry on;

opentelemetry_operation_name my_other_backend;

opentelemetry_propagate b3;

# Adds a custom attribute to the span

opentelemetry_attribute "req.time" "$msec";

proxy_pass http://http1;

}

}

}

3.8.2.3 Otel module 配置

Bash

exporter = "otlp"

processor = "batch"

[exporters.otlp]

#collector server address

# Alternatively the OTEL_EXPORTER_OTLP_ENDPOINT environment variable can also be used.

host = "192.168.40.136"

port = 4317

# Optional: enable SSL, for endpoints that support it

# use_ssl = true

# Optional: set a filesystem path to a pem file to be used for SSL encryption

# (when use_ssl = true)

# ssl_cert_path = "/path/to/cert.pem"

[processors.batch]

max_queue_size = 2048

schedule_delay_millis = 5000

max_export_batch_size = 512

[service]

# Can also be set by the OTEL_SERVICE_NAME environment variable.

name = "njet-proxy" # Opentelemetry resource name

[sampler]

name = "AlwaysOn" # Also: AlwaysOff, TraceIdRatioBased

ratio = 0.1

parent_based = false

3.8.3 启动collector以及Jaeger服务

通过docker-compose 启动collector 以及jaeger服务

若没有docker-compose,需先下载:

yum install docker-compose

然后执行:

docker-compose -f docker-compose.yaml up -d

docker-compose -f docker-compose.yaml down #停掉jager

docker-compose.yaml

version: "2"

services:

# Jaeger

jaeger-all-in-one:

image: jaegertracing/all-in-one:latest

restart: always

ports:

- "16686:16686"

- "14268"

- "14250"

# Zipkin

zipkin-all-in-one:

image: openzipkin/zipkin:latest

restart: always

ports:

- "9411:9411"

# Collector

otel-collector:

image: otel/opentelemetry-collector:0.67.0

restart: always

command: ["--config=/etc/otel-collector-config.yaml", "${OTELCOL_ARGS}"]

volumes:

- ./otel-collector-config.yaml:/etc/otel-collector-config.yaml

ports:

- "1888:1888" # pprof extension

- "8888:8888" # Prometheus metrics exposed by the collector

- "8889:8889" # Prometheus exporter metrics

- "13133:13133" # health_check extension

- "4317:4317" # OTLP gRPC receiver

- "4318:4318" # OTLP http receiver

- "55679:55679" # zpages extension

depends_on:

- jaeger-all-in-one

- zipkin-all-in-one

#demo-client:

# build:

# dockerfile: Dockerfile

# context: ./client

# restart: always

# environment:

# - OTEL_EXPORTER_OTLP_ENDPOINT=otel-collector:4317

# - DEMO_SERVER_ENDPOINT=http://demo-server:7080/hello

# depends_on:

# - demo-server

#demo-server:

# build:

# dockerfile: Dockerfile

# context: ./server

# restart: always

# environment:

# - OTEL_EXPORTER_OTLP_ENDPOINT=otel-collector:4317

# ports:

# - "7080"

# depends_on:

# - otel-collector

#prometheus:

# container_name: prometheus

# image: prom/prometheus:latest

# restart: always

# volumes:

# - ./prometheus.yaml:/etc/prometheus/prometheus.yml

# ports:

# - "9090:9090"

otel-collector-config.yaml

receivers:

otlp:

protocols:

grpc:

http:

exporters:

prometheus:

endpoint: "0.0.0.0:8889"

const_labels:

label1: value1

logging:

zipkin:

endpoint: "http://zipkin-all-in-one:9411/api/v2/spans"

format: proto

jaeger:

endpoint: jaeger-all-in-one:14250

tls:

insecure: true

processors:

batch:

extensions:

health_check:

pprof:

endpoint: :1888

zpages:

endpoint: :55679

service:

extensions: [pprof, zpages, health_check]

pipelines:

traces:

receivers: [otlp]

processors: [batch]

exporters: [logging, zipkin, jaeger]

metrics:

receivers: [otlp]

processors: [batch]

exporters: [logging, prometheus]

3.8.4 opentelemetry_sdk_log4cxx.xml(log 配置文件)

同其他njet 配置文件路径一致

<?xml version="1.0" encoding="UTF-8" ?>

<log4j:configuration xmlns:log4j="http://jakarta.apache.org/log4j/" debug="false">

<appender name="main" class="org.apache.log4j.ConsoleAppender">

<layout class="org.apache.log4j.PatternLayout">

<param name="ConversionPattern" value="%d{yyyy-MM-dd HH:mm:ss.SSS z} %-5p %X{pid}[%t] [%c{2}] %m%n" />

<param name="HeaderPattern" value="Opentelemetry Webserver %X{version} %X{pid}%n" />

</layout>

</appender>

<appender name="api" class="org.apache.log4j.ConsoleAppender">

<layout class="org.apache.log4j.PatternLayout">

<param name="ConversionPattern" value="%d{yyyy-MM-dd HH:mm:ss.SSS z} %-5p %X{pid} [%t] [%c{2}] %m%n" />

<param name="HeaderPattern" value="Opentelemetry Webserver %X{version} %X{pid}%n" />

</layout>

</appender>

<appender name="api_user" class="org.apache.log4j.ConsoleAppender">

<layout class="org.apache.log4j.PatternLayout">

<param name="ConversionPattern" value="%d{yyyy-MM-dd HH:mm:ss.SSS z} %-5p %X{pid} [%t] [%c{2}] %m%n" />

<param name="HeaderPattern" value="Opentelemetry Webserver %X{version} %X{pid}%n" />

</layout>

</appender>

<logger name="api" additivity="false">

<level value="info"/>

<appender-ref ref="api"/>

</logger>

<logger name="api_user" additivity="false">